Нове дослідження поєднує рекурентні нейронні мережі (RNN) з концепцією відпалу для вирішення реальних проблем оптимізації.

Завдання оптимізації включають визначення найбільш оптимальної відповіді з багатьох варіантів, які часто можна побачити як у реальних ситуаціях, так і в більшості областей наукових досліджень. Однак багато складних проблем не можуть бути вирішені простими обчислювальними методами або вимагають великих витрат часу.

Оскільки прості алгоритми є неефективними для вирішення цих проблем, експерти по всьому світу намагаються розробити більш ефективні стратегії, які можуть вирішити їх у реалістичні терміни. Штучні нейронні мережі. (ANN) лежать в основі деяких найбільш перспективних методів, вивчених на даний момент.

Нове дослідження, проведене Інститутом Вектора (Vector Institute), Університетом Ватерлоо та канадським інститутом теоретичної фізики Perimeter представляють варіаційний нейронний відпал. Цей новий метод оптимізації поєднує в собі рекурентні нейронні мережі (RNN) з поняття відпалу. Використовуючи параметризовану модель цей інноваційний метод узагальнює розподіл можливих рішень конкретної проблеми. Його мета полягає в тому, щоб вирішити реальні проблеми оптимізації з використанням нового алгоритму, заснованого на теорії відпалу та рекурентних мережах, що застосовуються в обробці природної мови (NLP).

Пропонована схема заснована на принципі відпалу, натхненна металургійним відпалом, який полягає в нагріванні матеріалу та його повільному охолодженні, щоб довести його до більш еластичного та стабільного стану з нижчою енергією. Імітація відпалу була розроблена на основі цього процесу для можливості знайти чисельне вирішення проблеми оптимізації.

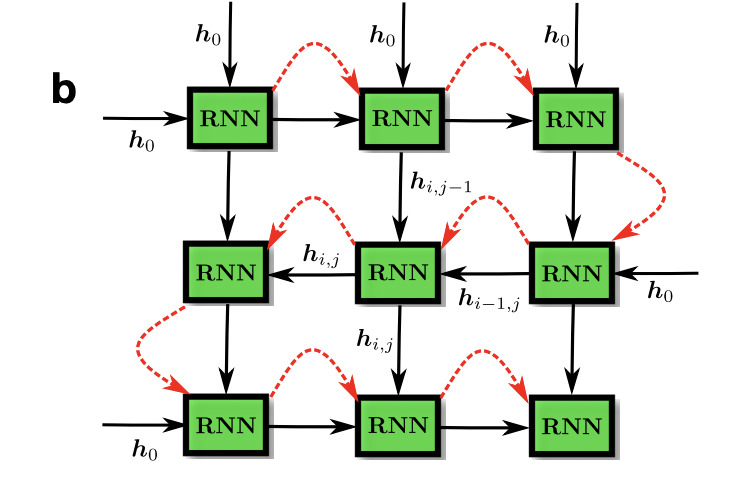

Найбільша відмінна риса цього оптимізації полягає в тому, що він поєднує в собі ефективність і продуктивність нейромереж з перевагами методів моделювання відпалу. Команда використовувала алгоритм RNN, який виявився особливо перспективним для застосування у NLP. Хоча ці алгоритми зазвичай використовуються для інтерпретації людської мови у дослідженнях NLP, дослідники використовували їх для вирішення оптимізації задач.

Порівняно з традиційнішими реалізаціями (чисельні методи) відпалу, їх метод на основі RNN дозволив отримати кращі рішення, підвищивши ефективність як класичних, так і квантових процедур відпалу. За допомогою авторегресійних мереж дослідники змогли закодувати парадигму відпалу. Їх стратегія виводить рішення задач оптимізації на новий рівень, безпосередньо використовуючи інфраструктури, що застосовуються для навчання сучасних нейронних мереж, таких як TensorFlow або Pytorch, з прискоренням як на GPU, так і на TPU.

Команда провела кілька тестів, щоб порівняти продуктивність методу із традиційними методами оптимізації відпалу, заснованими на чисельному моделюванні. У багатьох випадках із завдань оптимізації запропонований підхід перевершив усі методи.

У майбутньому цей алгоритм можна використовувати для вирішення широкого кола реальних завдань оптимізації, що дозволить експертам у різних галузях швидше вирішувати проблеми.

Надалі дослідники хотіли б оцінити продуктивність свого алгоритму більш реалістичних завданнях, і навіть порівняти його з продуктивністю існуючих методів оптимізації. Вони також мають намір покращити свою методику, замінивши деякі компоненти або додавши нові.

Цілком статтю можна переглянути тут.

Також є код на Github:

Variational Neural Annealing

Simulated Classical and Quantum Annealing