Машинне “відучування” захищає генеративний ШІ від проблем з авторськими правами

Коли справа доходить до навчання, люди і системи штучного інтелекту (ШІ) стикаються з однаковими труднощами: як забути інформацію, яку вони не повинні знати. Для програм штучного інтелекту, які швидко розвиваються, особливо для тих, що навчаються на великих наборах даних, ця проблема стає все більш критичною. Уявіть модель ШІ, яка ненавмисно генерує контент, використовуючи матеріали, які захищені авторським правом або які зображують насильство – такі ситуації можуть призвести до юридичних ускладнень та етичних проблем.

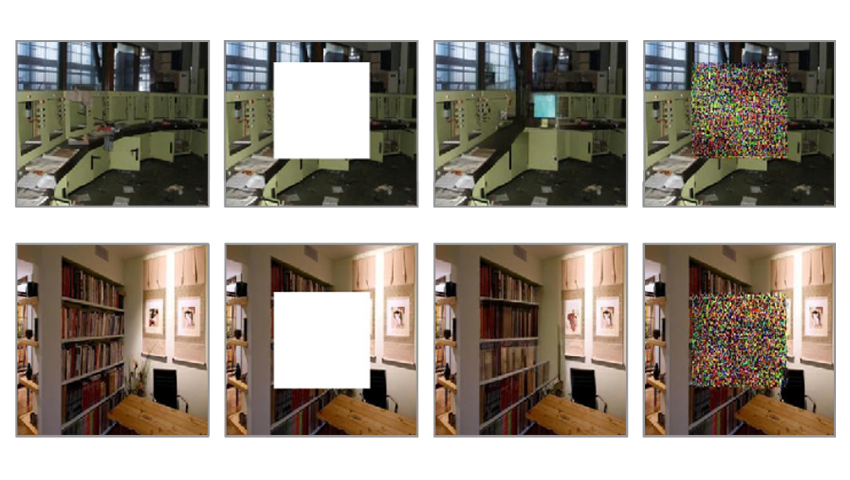

Дослідники з Техаського університету в Остіні впоралися з цією проблемою за допомогою новаторської концепції машинного "відучування" (machine “unlearning”). У своєму нещодавньому дослідженні команда вчених на чолі з Раду Маркулеску (Radu Marculescu) розробили метод, який дозволяє генеративним моделям ШІ вибірково забувати проблемний контент, не відкидаючи при цьому всю базу знань.

В основі їхнього дослідження використано моделі перетворення зображення в зображення (image-to-image), які здатні трансформувати вхідні зображення на основі контекстних підказок. Новий алгоритм машинного "забування" наділяє ці моделі здатністю видаляти позначений контент без проходження тривалого перенавчання. Спеціалісти-модератори контролюють видалення вмісту, забезпечуючи додатковий рівень нагляду та відповідного реагування на відгуки користувачів.

У той час як машинне "відучування" традиційно застосовувалося до класифікаційних моделей, його адаптація до генеративних моделей представляє новий рубіж. Генеративні моделі, особливо ті, що мають справу з обробкою зображень, стикаються з унікальними викликами. На відміну від класифікаторів, які приймають дискретні рішення, генеративні моделі створюють багатовимірні, безперервні результати. Забезпечення того, щоб вони забули певні аспекти без шкоди для своїх творчих здібностей, є складним проявом балансування.

На наступному етапі вчені планують дослідити застосовність методу до інших модальностей, особливо для моделей перетворення тексту в зображення (text-to-image). Дослідники також мають намір розробити ще кілька практичних бенчмарків (benchmarks) для тестування контролю вмісту під час генерації контенту та захисту конфіденційності даних.

З повним текстом дослідження можна ознайомитися в статті, опублікованій на сервері препринтів arXiv.

Оскільки штучний інтелект продовжує розвиватися, концепція машинного "відучення" відіграватиме все більш важливу роль. Це дозволяє моделям штучного інтелекту балансувати на тонкій межі між збереженням знань і відповідальним створенням нового контенту. Інтеграція людського контролю та вибіркового забування проблемного контенту наближає нас до моделей ШІ, які навчаються, адаптуються та дотримуються правових та етичних норм.