Досягнення МІТ: ШI генерує високоякісні зображення в 30 разів швидше

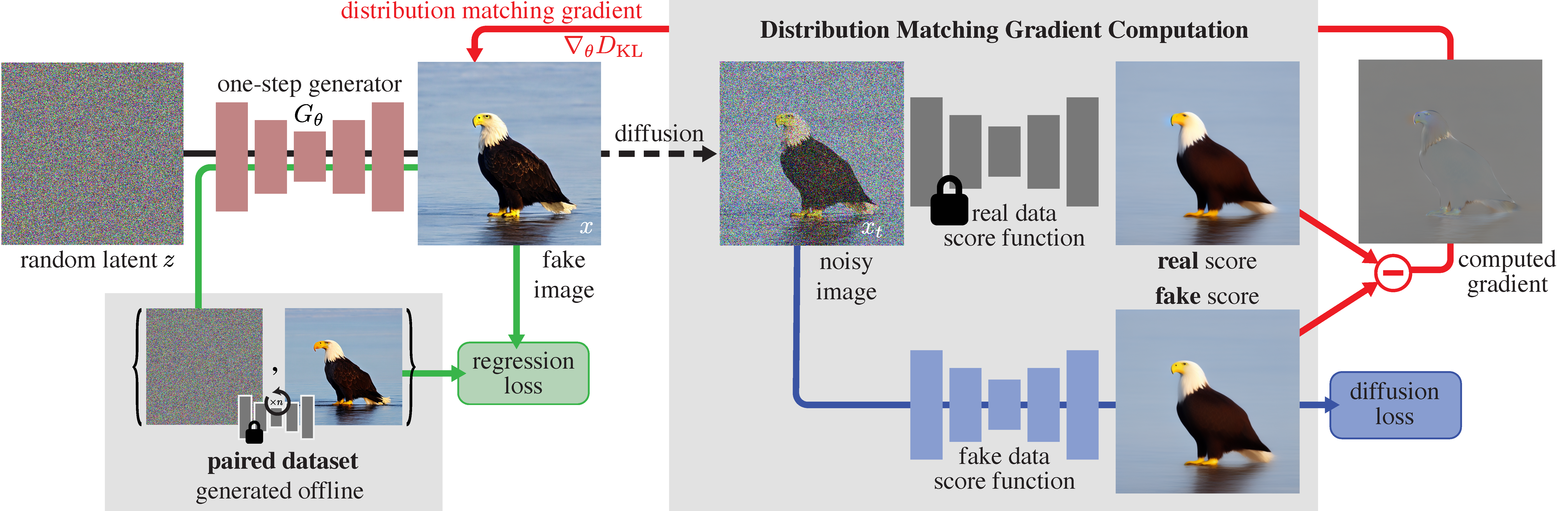

Дослідники Лабораторії комп'ютерних наук і штучного інтелекту (CSAIL) Массачусетського технологічного інституту (MIT) представили інноваційну систему під назвою Distribution Matching Distillation (DMD). Новий підхід спрощує традиційний багатоетапний процес створення моделей дифузії до одного кроку, усуваючи попередні обмеження.

Зазвичай генерація зображень була складним і трудомістким процесом, який передбачав численні ітерації для вдосконалення кінцевого результату. Однак нещодавно розроблений фреймворк DMD спрощує цей процес, значно скорочуючи час обчислень, зберігаючи або навіть перевершуючи якість згенерованих зображень. Дослідницька група під керівництвом Тяньвей Інь (Tianwei Yin), аспіранта МІТ, досягла вражаючого успіху: прискорила роботу існуючих моделей дифузії, таких як Stable Diffusion та DALL-E-3, у 30 разів. Порівняйте результати генерації зображення Stable Diffusion (зліва) після 50 кроків ітерації та DMD (справа) усього лиш після одного кроку. Якість та деталізація вражають!

Ключ до успіху DMD полягає в його інноваційному підході, який поєднує принципи генеративних змагальних мереж (GAN) з принципами дифузійних моделей. За допомогою перенесення знань більш складних моделей у простішу, швидшу модель, DMD досягає генерації візуального контенту за один крок.

Але як DMD досягає цього? Система поєднує дві складові:

1. Втрата регресії: закріплює відображення, забезпечуючи грубу організацію простору зображень під час навчання.

2. Втрата відповідності розподілу: вирівнює ймовірність генерування зображення з моделлю учня до частоти його появи в реальному світі.

Завдяки використанню двох моделей дифузії в якості орієнтирів, DMD мінімізує розбіжність розподілу між створеними і реальними зображеннями, що призводить до їх швидшої генерації без втрати якості.

У своєму дослідженні Інь та його колеги продемонстрували ефективність DMD у різних тестах продуктивності (benchmark). Зокрема, DMD показав стабільні результати під час проведення такого популярного бенчмарку, як ImageNet, досягнувши показника початкової відстані Фреше (FID) лише 0,3, що свідчить про якість і різноманітність згенерованих зображень. Крім того, DMD досягнув успіху в перетворенні тексту в зображення в промислових масштабах, продемонструвавши свою універсальність і практичне використання у реальному світі.

Незважаючи на свої видатні досягнення, продуктивність DMD нерозривно пов'язана з можливостями моделі вчителя, що використовується в процесі дистиляції. Хоча поточна версія використовує Stable Diffusion v1.5 як модель вчителя, у майбутніх ітераціях можуть використовуватися більш розвинені моделі, відкриваючи нові можливості для високоякісного візуального редагування в реальному часі.