Філософи vs перетворювачі: нейронна мережа уособлює відомого вченого-когнітивіста

Чи можуть комп’ютери мислити? Чи можуть моделі штучного інтелекту (ШІ) бути свідомими? Ці та подібні запитання часто виникають під час обговорення нещодавнього прогресу ШІ, досягнутого за допомогою моделей природної мови GPT-3, LAMDA та інших перетворювачів. Тим не менш, вони все ще суперечливі і знаходяться на межі парадоксу, тому що зазвичай існує безліч прихованих припущень і помилкових уявлень про те, як працює мозок і що означає мислення. Немає іншого шляху, окрім як точно обґрунтувати ці припущення, а потім дослідити, як саме обробка інформації людиною може бути відтворена машинами.

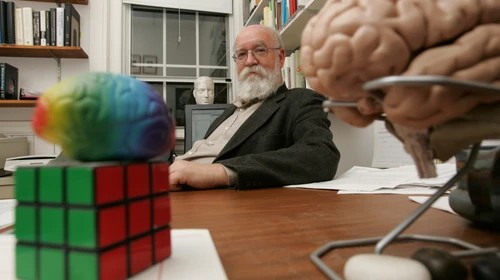

Нещодавно група вчених, які досліджують штучний інтелект, провела цікавий експеримент. Використовуючи популярну нейронну модель GPT-3 від Open AI, вони доопрацювали її повною збіркою робіт Деніела Деннета, американського філософа, письменника та когнітивіста, чиї дослідження зосереджені на філософії розуму та науки. Дослідники заявили, що їхня мета полягала в тому, щоб побачити, чи зможе модель ШІ відповідати на філософські питання так само, як відповів би на них філософ. Деннет особисто взяв участь в експерименті та відповів на десять філософських запитань, які потім були введені у доопрацьовану версію моделі трансформатора GPT-3.

Схема експерименту була простою і зрозумілою. І філософу, і комп'ютеру було поставлено десять запитань. Приклад питання: «Чи є свобода волі? Який вид чи види свободи варто мати?». Штучний інтелект отримав ті самі питання, доповнені контекстом, припускаючи, що питання взяті з інтерв’ю з Деннеттом. Далі відповіді комп'ютера були відфільтровані за таким алгоритмом: 1) відповідь була скорочена приблизно до довжини відповіді людини; 2) відповіді, що містять слова-підказки (наприклад, «інтерв'ю»), були виключені. На кожне запитання було отримано чотири відповіді, згенерованих штучним інтелектом, без відбору чи редагування.

Як оцінювалися результати? Рецензентам було запропоновано опитувальник, мета якого полягала в тому, щоб вибрати «правильну» відповідь із п'яти, де інші чотири - це відповіді штучного інтелекту. Опитування доступне онлайн для всіх бажаючих випробувати свої детективні навички. Ми рекомендуємо спробувати і вам, аби побачити, чи зможете ви досягти більшого успіху, ніж експерти:

https://ucriverside.az1.qualtrics.com/jfe/form/SV_9Hme3GzwivSSsTk

Результат не став зовсім несподіваним. "Навіть добре обізнаним філософам, які є експертами з робіт Дена Деннета, дуже важко відрізнити відповіді, створені цією програмою, від власних відповідей Деннета", - відмітив керівник дослідження. Відповіді учасників на деякі питання були не ліпше випадкових припущень і трохи краще на інші запитання.

Які висновки ми можемо зробити із цього дослідження? Чи означає це, що моделі, подібні до GPT, незабаром зможуть замінити людину в багатьох сферах? Чи має це якесь відношення до мислення, розуміння природної мови та штучного інтелекту? Чи буде машинне навчання забезпечувати результати на рівні людини і коли? Це важливі та цікаві питання, і ми ще далекі від остаточних відповідей.