RadiologyLlama-70B: Нова мовна модель для обробки радіологічних висновків

Дослідники з Університету Джорджії та Массачусетської загальної лікарні (MGH) створили спеціалізовану мовну модель RadiologyLlama-70B для роботи з радіологічними висновками. Побудована на основі Llama 3-70B, ця модель була навчена на масштабному наборі медичних даних і демонструє виняткові результати в аналізі та генерації висновків радіологів.

Контекст і значення

Радіологічні дослідження відіграють ключову роль у діагностиці захворювань, проте зростаючий обсяг даних створює значне навантаження на лікарів-радіологів. Штучний інтелект може значно полегшити цей процес, знижуючи робоче навантаження та підвищуючи точність діагностики. RadiologyLlama-70B є важливим кроком до інтеграції AI у клінічну практику, спрощуючи аналіз та інтерпретацію радіологічних звітів.

Навчальні дані та їх підготовка

Для навчання RadiologyLllama-70B використовували базу даних, що містить понад 6,5 мільйонів медичних звітів пацієнтів MGH за період 2008-2018 років. Як зазначають автори: "Ці комплексні медичні звіти охоплюють широкий спектр методів візуалізації та різні частини тіла. Методи візуалізації включають КТ (комп'ютерну томографію), МРТ (магнітно-резонансну томографію), рентгенографію, флюороскопію."

Набір даних включає:

- Детальні спостереження лікарів-радіологів (findings)

- Підсумкові висновки (impressions)

- Коди досліджень, що вказують на методи візуалізації (КТ, МРТ, рентгенографія, флюороскопія)

Після ретельної обробки та видалення персональних даних фінальний набір склав 4 354 321 звіт для навчання та 2 114 звітів для тестування. Також застосовувалися складні методи очищення даних, такі як видалення некоректних звітів, що дало змогу мінімізувати ризик "галюцинацій" моделі.

Технічні аспекти навчання

Модель налаштовували за допомогою двох основних підходів:

- Повне тонке налаштування (Full fine-tuning) – коригування всіх параметрів моделі.

- QLoRA – низькорангова адаптація з використанням 4-бітного квантування для підвищення обчислювальної ефективності.

Інфраструктура навчання

Навчання проводилося на кластері з 8 NVIDIA H100 GPU із використанням:

- Змішаної точності (BF16)

- Gradient checkpointing для оптимізації пам’яті

- DeepSpeed ZeRO Stage 3 для розподіленого навчання

Результати

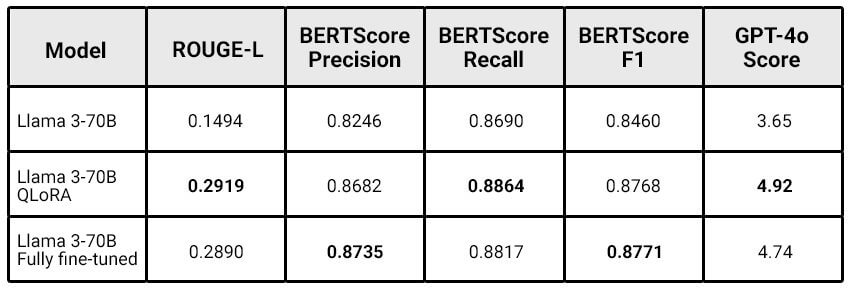

Порівняння моделі RadiologyLlama-70B із базовою моделлю (Llama 3-70B) показало суттєві покращення:

Цікаво, що модель із QLoRA показала результати, які співставні з повним тонким налаштуванням, але при цьому потребувала значно менше обчислювальних ресурсів. Дослідники зазначають: "Чим більша модель, тим більше переваг дає QLoRA fine-tune, дозволяючи досягати аналогічної продуктивності при менших витратах." Це підкреслює потенціал підходу QLoRA для масштабних моделей.

Обмеження

Дослідники чесно вказують на існуючі обмеження моделі:

- Відсутність порівняння з попередніми моделями, такими як

Radiology-llama2. - Не використовувалися останні версії Llama 3.1.

- Модель все ще може генерувати "галюцинації", що виключає повністю автоматичне використання для створення радіологічних звітів.

Майбутні напрями роботи

У межах подальших досліджень планується:

- Перенавчання моделі з використанням Llama 3.1-70B і тестування версії з 405B параметрами.

- Покращення очищення даних із застосуванням мовних моделей.

- Розробка методів виявлення "галюцинацій".

- Розширення методів оцінювання якості моделі з урахуванням клінічно значущих критеріїв.

Висновок

RadiologyLlama-70B являє собою значний крок вперед у застосуванні штучного інтелекту в радіології. Хоча модель ще не готова до повністю автономної генерації медичних звітів, вона демонструє великий потенціал у покращенні робочих процесів радіологів, забезпечуючи більш точні та релевантні висновки. Дослідження також наголошує на ефективності таких підходів, як QLoRA, для навчання спеціалізованих медичних моделей, відкриваючи нові можливості в медицині та суміжних галузях.

Детальніше ознайомитися з дослідженням можна в повній версії статті на arXiv.