Проходит ли GPT-4 тест Тьюринга?

Большие языковые модели (LLM), такие как GPT-4, по мнению многих, считаются технологическими чудесами, способными успешно проходить тест Тьюринга. Но насколько это соответствует действительности?

ChatGPT покорил вершины в области искусственного интеллекта (ИИ). Он может казаться умным, быстрым и впечатляющим. Он умело демонстрирует видимый интеллект, ведет разговоры с людьми, может подражать человеческому общению и даже проходит экзамены по юриспруденции. Однако, в некоторых случаях он все еще предоставляет совершенно ложную информацию.

Так может ли ChatGPT успешно пройти тест Тьюринга и создавать текст, неотличимый от ответа человека?

Двое исследователей из Университета Калифорнии в Сан-Диего изучили этот вопрос и получили интересные результаты. Кэмерон Джонс, специализирующийся на языке, семантике и машинном обучении, и Бенджамин Берген, профессор когнитивных наук, провели онлайн-тест Тьюринга. В ходе теста один человек пытался определить, является ли исследуемый субъект искусственным интеллектом или же человеком. В роли искусственного интеллекта выступал GPT-3.5 или GPT-4.

Эксперимент предполагал проведение онлайн-тестирования, включавшего диалоги между 650 участниками и моделями GPT. Участникам предлагалось определить, с кем они ведут беседу, человеком или ИИ. Конфигурации GPT-3.5 и GPT-4 изменялись в ходе эксперимента. Значительной частью исследования стал промпт, который направлял LLM на определенную тематику и стиль разговора. Этот промпт задавал характер взаимодействия и личности агента, и его меняли, чтобы выяснить, как он влияет на результат.

Каждый диалог имел ограничение времени – 5 минут, и ограничение по объему сообщения – менее 300 символов. Всего в эксперименте участвовало 652 судьи, которые завершили 1810 “игр”. После исключения подозрительных результатов число “игр” сократилось до 1405.

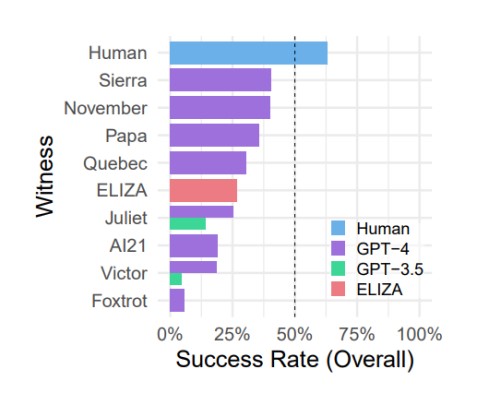

Результаты показали, что в 41% случаев модели GPT-4 смогли обмануть участников, в то время как модели GPT-3.5 справились лишь в 5 – 14% случаев. Для сравнения, старая модель ELIZA (1966) набрала целых 27% случаев признания ее человеком. Кроме этого, обнаружили интересный факт: участникам удалось убедить других участников, что они не являются машинами только в 63% случаев.

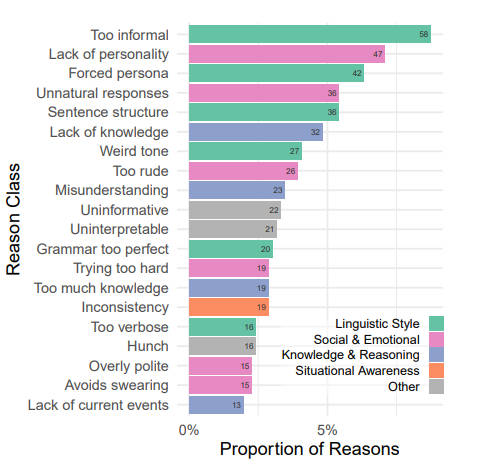

Достаточно любопытным моментом оказались мотивы, по которым участники принимали свои решения. Причины, по которым ИИ считался ИИ были следующими. Если искусственный интеллект казался слишком формальным или неформальным, это могло вызывать у них беспокойство. Аналогично, слишком многословные или слишком краткие ответы, странный тон разговора или идеальная грамматика становились важными факторами в определении, является ли собеседник человеком или машиной. Также стоит отметить, что недостаток знаний оказывался важнее излишества знаний. Возможно, моделям искусственного интеллекта следует продолжать учиться. Участники тестирования также проявляли чувствительность к общим ответам.

Исследователи пришли к выводу, что на основе данного эксперимента нельзя утверждать, что GPT-4 успешно прошел тест Тьюринга. Несмотря на это, показатель успешных обманов на уровне 41% свидетельствует о том, что использование искусственного интеллекта для обмана становится все более реальным. Особенно это актуально в ситуациях, где собеседники-люди менее внимательны к возможности общения с машиной.

Модели искусственного интеллекта, способные с успехом имитировать человеческие ответы, имеют потенциал повлечь за собой широкие социальные и экономические последствия. Станет все более важным отслеживать модели ИИ и определять факторы, которые приводят к обману, а также разрабатывать стратегии по его смягчению. Тем не менее, исследователи подчеркивают, что тест Тьюринга по-прежнему остается важным инструментом для измерения машинного диалога и понимания взаимодействия человека с искусственным интеллектом.

С удивлением можно отметить, как быстро мы достигли времен, когда технические системы могут соревноваться с человеком в области общения. Несмотря на сомнения в успехе GPT-4 в данном тесте, его результаты указывают на то, что мы приближаемся к созданию искусственного интеллекта, способного конкурировать с человеком в диалогах.

Ознакомиться с исследованиями можно здесь.