Как чат-боты и роботы после совершенных ошибок могут вернуть доверие людей

При взаимодействии с людьми роботы могут совершать ошибки, нарушая доверие человека к ним. Люди начинают считать роботов ненадежными. Различные стратегии восстановления доверия, применяемые роботами, могут быть использованы для смягчения негативных последствий этих нарушений доверия. Тем не менее, неясно, могут ли такие стратегии полностью восстановить доверие и насколько они эффективны после неоднократных нарушений доверия.

Поэтому ученые из Мичиганского университета решили провести исследование стратегий поведения роботов с целью восстановления доверия между ним и человеком. Этими стратегиями доверия были извинения, опровержения, объяснения и обещания надежности.

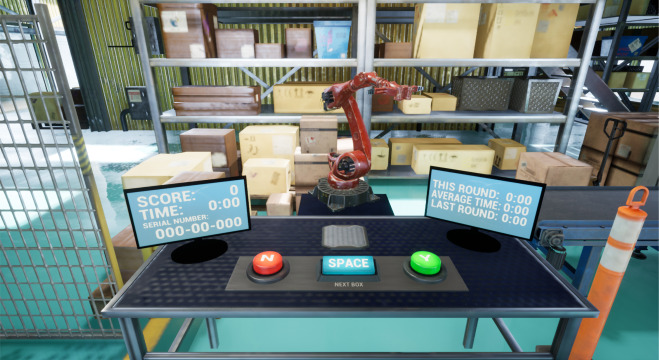

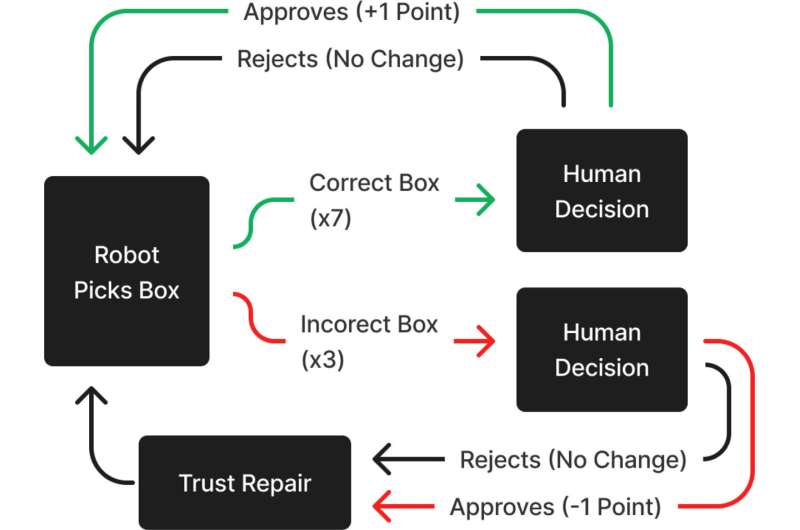

Был проведен эксперимент, в котором 240 участников работали с коллегой-роботом над выполнением задачи, в которой иногда робот совершал ошибки. Робот нарушал доверие участника, а затем предлагал определенную стратегию восстановления доверия. Участники были задействованы в качестве членов команды, а общение пары человек-робот происходило через интерактивную виртуальную среду, разработанную в Unreal Engine 4.

Эта среда была смоделирована так, чтобы выглядеть как настоящий склад. Участники располагались за столом с двумя дисплеями и тремя кнопками. На дисплеях показывался текущий счет команды, скорость обработки ящиков и серийный номер, необходимый участникам для оценки ящика, представленного их товарищем по команде – роботом. Счет каждой команды увеличивался на 1 очко каждый раз, когда на ленту конвейера помещалась правильная коробка, и уменьшался на 1 очко каждый раз, когда на конвейер ставилась неправильная коробка. В тех случаях, когда робот выбирал не тот ящик, и участники отмечали это как ошибку, на экране появлялся индикатор и указывал, что этот ящик неверен, но очки не присуждались и не вычитались из счета команды.

“Чтобы проверить наши гипотезы, мы использовали план между субъектами с четырьмя условиями восстановления и двумя условиями контроля”, – пояснил Коннор Эстервуд, исследователь из UM School of Information и ведущий автор исследования.

Условия контроля принимали форму молчания робота после совершения ошибки. Робот не пытался никак восстановить доверие человека, он просто сохранял молчание. Также в случае идеальной работы робота без совершения ошибок во время эксперимента он тоже ничего не говорил.

Условия восстановления, используемые в этом исследовании, были извинениями, опровержениями, объяснениями или обещаниями. Они применялись после каждой ошибки. При условии извинения робот говорил: “Мне жаль, что я получил не ту коробку в тот раз”. В случае отказа робот заявлял: “В тот раз я выбрал правильную коробку, значит, что-то еще пошло не так”. Для объяснений робот использовал фразу: “Я вижу, это был неправильный серийный номер”. И, наконец, что касается условия обещаний, робот говорил: “В следующий раз я сделаю лучше и возьму правильную коробку”.

Каждый из этих ответов был разработан, чтобы представить только один тип стратегии восстановления и избежать непреднамеренного объединения двух или более стратегий. Во время эксперимента участникам сообщали об этих исправлениях как с помощью аудио, так и текстовых субтитров. Примечательно, что робот только временно изменял свое поведение после того, как одна из стратегий восстановления доверия была реализована, извлекая правильные ящики еще два раза, пока не произошла следующая ошибка.

Для подсчета данных исследователи использовали серию непараметрических тестов суммы рангов Крускала-Уоллиса. Далее следовали апостериорные тесты множественных сравнений Данна с поправкой Бенджамини-Хохберга для контроля множественной проверки гипотез.

“Мы выбрали эти методы вместо других, потому что данные в этом исследовании не имели нормального распределения. В первом из этих тестов мы изучали наши манипуляции с надежностью и сравнивали различия в надежности между состоянием идеальной производительности и состоянием отсутствия восстановления доверия. Во втором тесте использовались три отдельных теста Крускала-Уоллиса, за которыми следовали апостериорные исследования для определения оценок способностей и доброжелательности участников при попытках восстановления доверия”, – отметили Эстервуд и Роберт Лайонел, профессор информации и соавтор исследований.

Основные результаты исследования:

- Никакая стратегия восстановления доверия полностью не восстанавливала надежность робота.

- Извинения, объяснения и обещания не могли восстановить представления о способностях.

- Извинения, объяснения и обещания не могли восстановить представление о честности.

- Извинения, объяснения и обещания в равной степени восстановили доброжелательность робота.

- Отказы не могли восстановить представление о надежности робота.

- После трех ошибок ни одна из стратегий восстановления доверия никогда полностью не восстанавливала надежность робота.

Результаты исследования имеют два следствия. Эстервуд отметил, что исследователи должны разработать более эффективные стратегии восстановления, чтобы помочь роботам лучше восстанавливать доверие после этих ошибок. Кроме того, роботы должны быть уверены, что они справились с новой задачей, прежде чем пытаться восстановить доверие человека к ним.

“В противном случае они рискуют потерять доверие человека к себе таким образом, что его невозможно будет восстановить”, – сказал Эстервуд.