Машинное "разобучение" защищает генеративный ИИ от проблем с авторским правом

Когда дело доходит до обучения, люди и системы искусственного интеллекта (ИИ) сталкиваются с одинаковыми трудностями: как забыть информацию, которую они не должны знать. Для быстро развивающихся программ искусственного интеллекта, особенно для обучающихся на больших наборах данных, эта проблема становится все более критичной. Представьте модель ИИ, которая непреднамеренно генерирует контент, используя материалы, защищенные авторским правом или изображающие насилие – такие ситуации могут привести к юридическим осложнениям и этическим проблемам.

Исследователи из Техасского университета в Остине справились с этой проблемой с помощью новаторской концепции машинного "разобучения" (machine “unlearning”). В своем недавнем исследовании команда ученых во главе с Раду Маркулеску (Radu Marculescu) разработали метод, позволяющий генеративным моделям ИИ избирательно забывать проблемный контент, не отвергая при этом всю базу знаний.

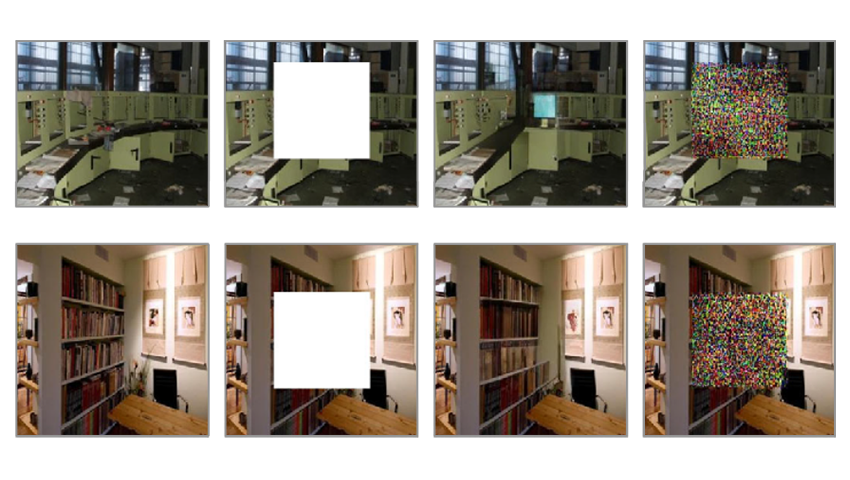

В основе их исследования использованы модели преобразования изображения в изображение (image-to-image), которые способны трансформировать входные изображения на основе контекстных подсказок. Новый алгоритм машинного "забывания" наделяет эти модели способностью удалять помеченный контент без прохождения длительного переучивания. Специалисты-модераторы контролируют удаление содержимого, обеспечивая дополнительный уровень контроля и соответствующего реагирования на отзывы пользователей.

В то время как машинное "разобучение" традиционно применялось к классификационным моделям, его адаптация к генеративным моделям представляет новый рубеж. Генеративные модели, особенно те, что имеют дело с обработкой изображений, сталкиваются с уникальными задачами. В отличие от классификаторов, принимающих дискретные решения, генеративные модели создают многомерные, непрерывные результаты. Обеспечение того, чтобы они забыли определенные аспекты, не затрагивая при этом свои творческие способности, требует тонкого баланса.

В дальнейшем ученые планируют исследовать применимость метода к другим модальностям, особенно для моделей преобразования текста в изображение (text-to-image). Исследователи также намерены разработать еще несколько практических бенчмарков (benchmarks) для тестирования контроля содержания во время генерации контента и защиты конфиденциальности данных.

С полным текстом исследования можно ознакомиться в статье, опубликованной на сервере препринтов arXiv.

Поскольку искусственный интеллект продолжает развиваться, концепция машинного "разобучения" будет играть все более важную роль. Это позволяет моделям искусственного интеллекта балансировать на тонкой грани между сохранением знаний и ответственным созданием нового контента. Интеграция человеческого контроля и выборочного забывания проблемного контента приближает нас к моделям ИИ, которые учатся, адаптируются и соблюдают правовые и этические нормы.