Mamba-3 – новая эра в языковом моделировании

С разработкой Mamba-3 в мире искусственного интеллекта начался новый этап. Mamba-3 – это передовая нейронная архитектура, которая устанавливает новые стандарты производительности, эффективности и возможностей для больших языковых моделей (LLM).

Mamba-3 продолжает развитие идеи, возникшей еще в 2023 году с появлением оригинальной архитектуры Mamba. В отличие от трансформеров (Transformers), которые почти десятилетие доминировали в языковом моделировании, Mamba опирается на модели состояния (State Space Models, SSM) – класс моделей, изначально созданных для прогнозирования непрерывных последовательностей в таких областях, как теория управления и обработка сигналов.

Трансформеры, несмотря на свою мощность, имеют серьезный недостаток – квадратичный рост потребностей в памяти и вычислениях с удлинением последовательности, что создает “узкое место” при обучении и инференсе. Модели Mamba, напротив, обеспечивает линейное или даже постоянное использование памяти во время инференса, что позволяет эффективно работать с чрезвычайно длинными последовательностями. При этом Mamba достигает или превосходит точность моделей Transformer аналогичного размера на стандартных бенчмарках, существенно сокращая задержку и уменьшая требования к аппаратному обеспечению.

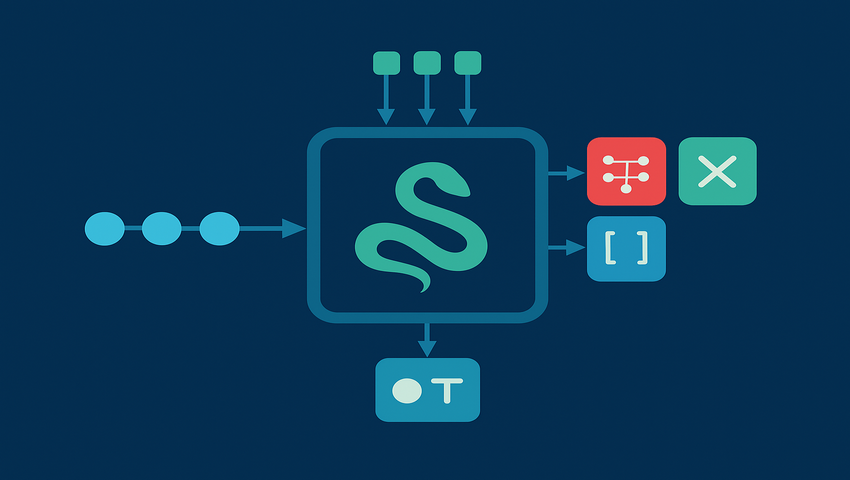

Основное преимущество Mamba заключается в ее модели выборочного пространства состояний (Selective State Space Model, S6), которая обеспечивает избирательное внимание, подобное трансформеру. Благодаря динамической регулировке приоритетов предыдущих входных данных, модели Mamba могут сосредоточиться на релевантном контексте, “забывая” несущественную информацию. Это достигается с помощью обновлений состояний, которые зависят от входных данных. В сочетании с параллельным сканированием, учитывающим аппаратное обеспечение, эти модели могут эффективно выполнять масштабные вычисления на графических процессорах (GPU), максимизируя пропускную способность без потери качества.

Mamba-3 имеет несколько уникальных особенностей, которые отличают ее от предшественников:

- Трапецеидальная дискретизация (Trapezoidal Discretization) – повышает выразительность SSM и уменьшает потребность в коротких свертках, что улучшает результаты в задачах языкового моделирования.

- Комплексное обновление пространства состояний (Complex State-Space Updates) – позволяет модели отслеживать сложные зависимости, выполняя логические и арифметические операции, ранее недоступные для предыдущих версий Mamba.

- Многоканальный вход и выход для SSM (Multi-Input, Multi-Output (MIMO) SSM) – увеличивает эффективность инференса, повышая интенсивность вычислений и использование аппаратных ресурсов без дополнительной нагрузки на память.

Эти инновации в сочетании с архитектурными усовершенствованиями, такими как QK-нормализация и индивидуальные смещения, гарантируют, что Mamba-3 не только обеспечивает превосходную производительность, но и в полной мере использует аппаратные возможности.

По результатам всестороннего тестирования, Mamba-3 демонстрирует сопоставимые или более высокие показатели в задачах языкового моделирования, отслеживания состояний и извлечения информации, чем модели Transformer, Mamba-2 и Gated DeltaNet. Благодаря своей SSM-архитектуре модель сохраняет долгосрочный контекст, а избирательный механизм обеспечивает использование только релевантной информации – ключевой фактор для моделирования последовательностей.

Впрочем, Mamba-3 имеет определенные ограничения. Архитектуры с фиксированным состоянием пока уступают моделям с механизмом внимания (attention) в сложных задачах поиска и извлечения контекста. Исследователи видят перспективу в создании гибридных архитектур, которые объединят эффективность Mamba с механизмами поиска, присущими трансформерам.

Mamba-3 – это не просто очередное обновление, а переосмысление принципов построения нейронных сетей, сочетающее скорость, масштабируемость и точность. Используя принципы структурированных SSM и обновления состояния в зависимости от входных данных, Mamba-3 бросает вызов доминированию трансформеров в языковом моделировании, предлагая жизнеспособную альтернативу, которая плавно масштабируется как по длине последовательности, так и по ограничениям аппаратного обеспечения.