MAIA: автоматизированный агент для интерпретации моделей ИИ

Системы искусственного интеллекта (ИИ) становятся все более сложными, и понимание их внутренней работы имеет решающее значение для обеспечения их безопасности, справедливости и прозрачности. Исследователи из Лаборатории компьютерных наук и искусственного интеллекта Массачусетского технологического института (CSAIL) представили инновационное решение под названием "MAIA" (Multimodal Automated Interpretability Agent), систему, которая автоматизирует интерпретацию нейронных сетей.

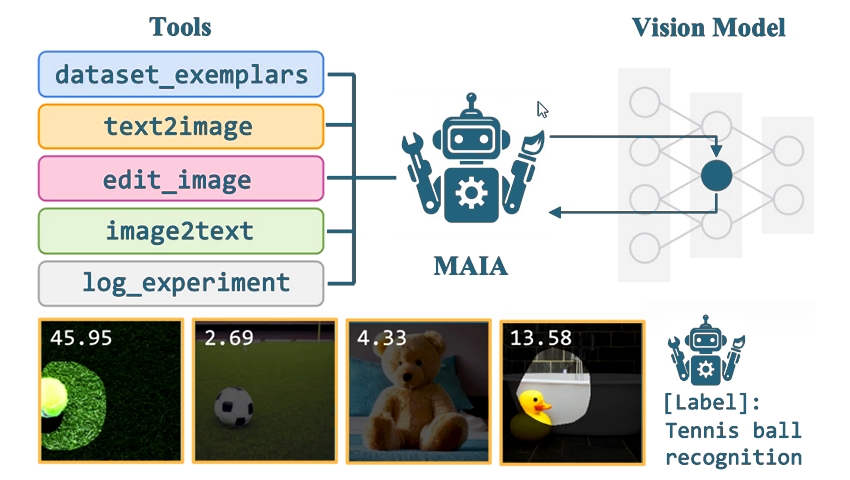

MAIA разработана для решения проблемы понимания больших и сложных моделей ИИ. Она автоматизирует процесс интерпретации моделей компьютерного зрения, которые оценивают различные свойства изображений. MAIA использует основу языковой модели и модели компьютерного зрения в сочетании с библиотекой инструментов интерпретации, что позволяет проводить эксперименты на других системах ИИ.

По словам Тамар Ротт Шахам (Tamar Rott Shaham), соавтора научной статьи, их целью было создать ИИ-исследователя, который может автономно проводить эксперименты по интерпретации. Поскольку существующие методы только маркируют или визуализируют данные в одномоментном процессе, MAIA вместо этого может генерировать гипотезы, разрабатывать эксперименты для их проверки и совершенствовать свое понимание с помощью итерационного анализа.

Возможности MAIA продемонстрированы в трех ключевых задачах:

- Маркировка компонентов: MAIA идентифицирует отдельные компоненты в моделях компьютерного зрения и описывает визуальные концепции, которые их активируют.

- Очистка моделей: удаляя нерелевантные признаки из классификаторов изображений, MAIA повышает их надежность в новых ситуациях.

- Выявление предубеждений: MAIA ищет скрытые предубеждения, помогая выявить потенциальные проблемы со справедливостью в результатах ИИ.

Одной из заметных особенностей MAIA является ее способность описывать концепции, обнаруженные отдельными нейронами в модели компьютерного зрения. Например, пользователь может попросить MAIA определить, что обнаруживает определенный нейрон. MAIA получает из ImageNet образцы набора данных, которые максимально активируют нейрон, выдвигает гипотезу о причинах активности нейрона и планирует эксперименты для проверки этих гипотез. Создавая и редактируя синтетические изображения, MAIA может выделить конкретные причины активности нейрона, подобно научному эксперименту.

Объяснения MAIA оцениваются с помощью синтетических систем с известным поведением и новых автоматизированных протоколов для реальных нейронов в тренированных системах ИИ. Метод, разработанный в CSAIL, превзошел базовые методы в описании нейронов в различных моделях зрения, часто достигая качества, которое предоставляют реальные эксперты.

Сфера интерпретации развивается вместе с развитием моделей машинного обучения «черного ящика». Современные методы часто ограничены в масштабе или точности. Целью исследователей было построить гибкую, масштабируемую систему, чтобы ответить на различные вопросы интерпретации. Выявление предубеждений в классификаторах изображений было критически важной задачей. Например, MAIA обнаружила ошибку в классификаторе, который неправильно классифицировал изображения черных лабрадоров, тогда как он правильно классифицировал желтошерстных ретриверов.

Несмотря на свои сильные стороны, эффективность MAIA ограничена качеством внешних инструментов. С улучшением моделей синтеза изображений и других инструментов эффективность MAIA также будет расти. Исследователи также внедрили инструмент преобразования изображения в текст, чтобы уменьшить количество подтверждающих предубеждений и проблем с переобучением.

В будущем исследователи планируют применить подобные эксперименты к человеческому восприятию. Традиционно тестирование зрительного восприятия человека было трудоемким. С помощью MAIA этот процесс можно масштабировать, потенциально позволяя сравнивать человеческое и искусственное зрительное восприятие.

Понять нейронные сети трудно из-за их сложности. MAIA помогает преодолеть этот пробел, автоматически анализируя нейроны и отчитываясь о результатах в понятной форме. Масштабирование этих методов может иметь решающее значение для понимания систем ИИ и контроля за ними.

Вклад MAIA выходит за пределы академических кругов. С ростом роли ИИ в различных отраслях интерпретация его поведения имеет важное значение. MAIA устраняет разрыв между сложностью и прозрачностью, делая системы ИИ более подотчетными. Оснастив исследователей инструментами искусственного интеллекта, которые идут в ногу с масштабированием систем, мы сможем лучше понять и решить проблемы, связанные с новыми моделями ИИ.

Более подробная информация об исследовании опубликована на сервере препринтов arXiv.