Философы vs преобразователи: нейронная сеть выдает себя за известного ученого-когнитивиста

Могут ли компьютеры думать? Могут ли модели искусственного интеллекта (ИИ) быть сознательными? Эти и подобные вопросы часто возникают при обсуждении недавнего прогресса ИИ, достигнутого с помощью моделей естественного языка GPT-3, LAMDA и других преобразователей. Тем не менее они все еще противоречивы и находятся на грани парадокса, потому что обычно существует множество скрытых предположений и ошибочных представлений о том, как работает мозг и что означает мышление. Нет другого пути, кроме как точно сформулировать эти предположения, а затем исследовать, как именно обработка информации человеком может быть воспроизведена машинами.

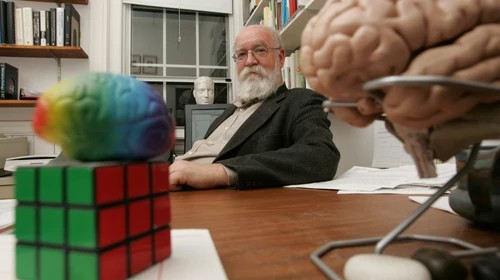

Недавно группа ученых, исследующих искусственный интеллект, провела интересный эксперимент. Используя популярную нейронную модель GPT-3 от Open AI, они доработали ее всем собранием работ Дэниела Деннета, американского философа, писателя и когнитивиста, чьи исследования сосредоточены на философии разума и науки. Исследователи заявили, что их цель состояла в том, чтобы увидеть, сможет ли модель ИИ отвечать на философские вопросы так же, как ответил бы сам философ. Деннет лично принял участие в эксперименте и ответил на десять философских вопросов, которые затем были введены в доработанную версию модели трансформатора GPT-3.

Схема эксперимента проста и понятна. И философу, и компьютеру было задано десять вопросов. Пример вопроса: «Есть ли у людей свобода воли? Каким видом или видами свободы стоит обладать?». ИИ задавались те же вопросы, дополненные контекстом, предполагая, что эти вопросы входили в интервью с Деннетом. Далее ответы компьютера фильтровались по следующему алгоритму: 1) ответ усекался примерно до длины ответа человека; 2) ответы, содержащие разоблачающие слова (например, «интервью»), были исключены. На каждый вопрос было получено четыре ответа, сгенерированных искусственным интеллектом, и никакой выборки или редактирования не производилось.

Как оценивались результаты? Рецензентам был представлен опросник, цель которого состояла в том, чтобы выбрать «правильный» ответ из пяти, где остальные четыре - это ответы искусственного интеллекта. Опрос доступен онлайн для всех желающих испытать свои детективные навыки. Мы рекомендуем попробовать и вам, чтобы увидеть, сможете ли вы добиться большего успеха, чем эксперты:

https://ucriverside.az1.qualtrics.com/jfe/form/SV_9Hme3GzwivSSsTk

Результат не стал совсем уж неожиданным. «Даже хорошо осведомленным философам, которые являются экспертами по работам Дэна Деннета, очень трудно отличить ответы, созданные этой программой, от собственных ответов Деннета», — прокомментировал руководитель исследования. Ответы участников на некоторые вопросы были ненамного лучше случайного предположения и чуть точнее на другие.

Какие выводы мы можем сделать из этого исследования? Означает ли это, что модели, подобные GPT, вскоре смогут заменить человека во многих областях? Имеет ли это какое-то отношение к мышлению, пониманию естественного языка и общему искусственному интеллекту? Будет ли машинное обучение производить результаты на уровне человека и когда? Это важные и интересные вопросы, и мы еще далеки от окончательных ответов.