RadiologyLlama-70B: Новая языковая модель для обработки радиологических заключений

Исследователи из Университета Джорджии и Массачусетского главного госпиталя (MGH) разработали специализированную языковую модель RadiologyLlama-70B для работы с радиологическими заключениями. Этот проект, основанный на Llama 3-70B, обучен на масштабной базе медицинских данных и демонстрирует очень хорошие результаты в анализе и генерации радиологических заключений.

Контекст и значение

Радиологические исследования играют ключевую роль в диагностике заболеваний, однако растущий объем данных создает значительную нагрузку на врачей-радиологов. Искусственный интеллект может существенно оптимизировать этот процесс, снижая рабочую нагрузку и повышая качество диагностики. RadiologyLlama-70B представляет собой шаг к внедрению AI в клиническую практику, облегчая анализ и интерпретацию радиологических заключений.

Обучающие данные и их подготовка

Для обучения RadiologyLlama-70B использовалась база данных, содержащая более 6,5 миллионов медицинских отчетов пациентов MGH за период 2008–2018 годов. Как отмечают авторы: "Эти комплексные медицинские отчеты охватывают широкий спектр методов визуализации и различные части тела. Методы визуализации включают КТ (компьютерную томографию), МРТ (магнитно-резонансную томографию), рентгенографию, флюороскопию."

Эти данные включают:

- Детальные наблюдения радиологов (findings)

- Итоговые заключения (impressions)

- Коды исследований, указывающие на методы визуализации (КТ, МРТ, рентгенография и флюороскопия)

После тщательной обработки и удаления персональных данных итоговый набор составил 4 354 321 отчет для обучения и 2 114 отчетов для тестирования. Также применялись сложные методы очистки данных, такие как удаление некорректных отчетов, что позволило минимизировать риск "галлюцинаций" модели.

Технические аспекты обучения

Модель обучалась с использованием двух подходов:

- Полная тонкая настройка (Full fine-tuning) — настройка всех параметров модели.

- QLoRA — низкоранговая адаптация с 4-битным квантованием для повышения эффективности вычислений.

Инфраструктура

Обучение проводилось на кластере из 8 GPU NVIDIA H100, используя:

- Смешанную точность (BF16)

- Gradient checkpointing для оптимизации памяти

- DeepSpeed ZeRO Stage 3 для распределенного обучения

Результаты

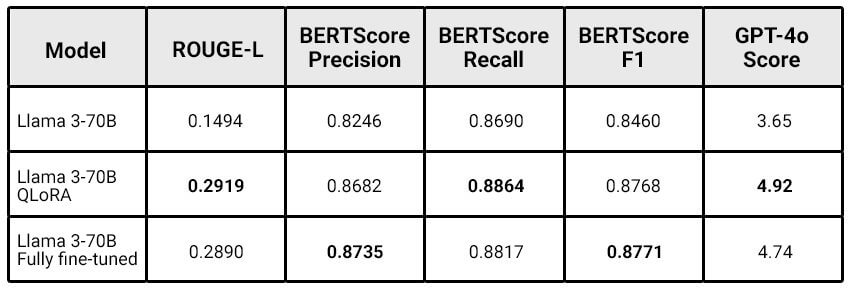

Сравнение производительности RadiologyLlama-70B с базовой моделью Llama 3-70B показало значительные улучшения:

Интересно, что модель с QLoRA показала результаты, сопоставимые с полной настройкой, при существенно меньших вычислительных затратах. Авторы отмечают: "Чем больше модель, тем больше преимуществ может дать QLoRA fine-tune, позволяя достичь схожей производительности при гораздо меньших вычислительных ресурсах." Это подчеркивает потенциал подхода QLoRA для масштабных моделей.

Ограничения

Исследователи честно указывают на существующие ограничения модели:

- Отсутствие сравнения с предыдущими моделями, такими как

Radiology-llama2. - Не использовались новейшие версии Llama 3.1.

- Модель все еще может демонстрировать "галлюцинации" (генерировать неверные заключения), что исключает полностью автоматическое применение к генерации заключений.

Будущие направления работы

В рамках дальнейших исследований планируется:

- Переобучение на

Llama 3.1-70Bи тестирование версии с 405B параметрами. - Улучшение очистки данных с использованием языковых моделей.

- Разработка методов обнаружения "галлюцинаций".

- Расширение методов оценки качества модели с учетом клинически значимых критериев.

Заключение

RadiologyLlama-70B представляет собой значительный шаг вперед в применении искусственного интеллекта в радиологии. Хотя модель еще не готова к автономной генерации заключений, она демонстрирует потенциал для существенного улучшения рабочего процесса радиологов, обеспечивая более точные и релевантные заключения. Исследование подчеркивает эффективность подходов, таких как QLoRA, для обучения специализированных медицинских задач, что открывает новые возможности в медицине и смежных областях.

Для тех, кто хочет узнать больше о применении ML в медицине, рекомендуем ознакомиться с полной версией статьи на сайте arXiv.