OpenAI звинувачує "найманця" в маніпулюванні результатами ШІ в позові New York Times про порушення авторських прав. Звинувачення у хакерстві та оманливих підказках були висунуті у поданні до федерального суду.

Роботи-дзвінки, які видавали себе за президента Байдена, збивали з пантелику виборців у Нью-Гемпширі. ШІ втручався у вибори в США. Підроблені дзвінки, пов'язані з техаськими компаніями.

Зображення, створені штучним інтелектом, стають нерозрізненими з реальністю, кидаючи виклик нашому сприйняттю та підриваючи довіру. Чи запропонують фейки в таких галузях, як модельний бізнес, більш різноманітну репрезентацію людства, чи увічнять вузькі стандарти краси?

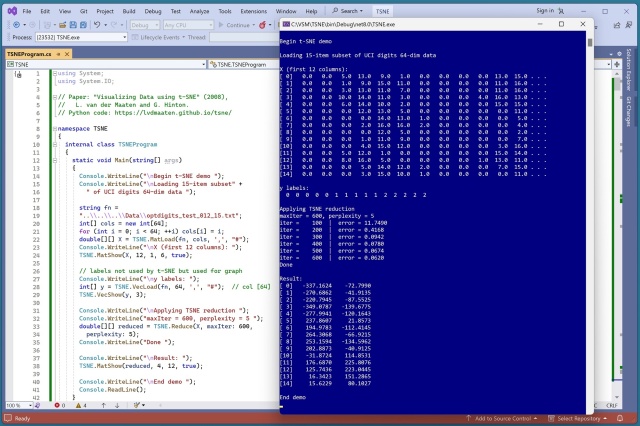

t-SNE - це потужна техніка для візуалізації багатовимірних даних, яка перетворює їх у 2D XY-графік. Реалізуйте її на C# для кращого розуміння та візуалізації наборів даних, таких як цифри UCI.

Експерименти Андерсон зі штучним інтелектом, у тому числі з моделлю її покійного чоловіка Лу Ріда, інтригують друзів. Художниця заглиблюється в атмосферу "Чорного дзеркала" за допомогою генератора тексту, що імітує стиль Ріда.

Імплантати Neuralink Ілона Маска дають надію на викорінення мозкових розладів, але викликають етичні занепокоєння. Заснована у 2016 році, компанія Neuralink є піонером у створенні інтерфейсів між мозком і машиною, що дозволяє контролювати розум роботів і потенційно змінювати їхні думки та поведінку.

Wendy's запровадить динамічне ціноутворення та функції меню зі штучним інтелектом у 2025 році, інвестувавши 30 мільйонів доларів у цифрову модернізацію. Ініціатива має на меті покращити клієнтський досвід та стимулювати зростання цифрового бізнесу.

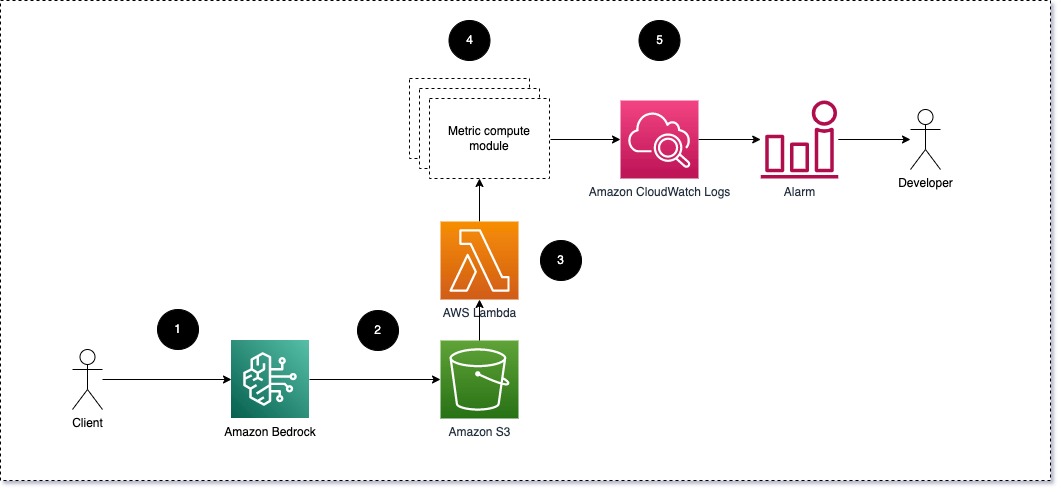

LLM трансформували завдання NLP, але моніторинг їхньої продуктивності має вирішальне значення. Наша масштабована архітектура AWS пропонує візуалізацію в режимі реального часу та настроювані рішення для онлайн-моніторингу LLM, включаючи відстеження метрик семантичної схожості за допомогою вбудовувань.

Нові графічні процесори NVIDIA RTX 500 і 1000 покоління Ada для ноутбуків пропонують потужне прискорення ШІ для професіоналів у дорозі, підвищуючи продуктивність і ефективність у різних галузях. Покращені NPU і RTX GPU, ці графічні процесори забезпечують до 14 разів більшу продуктивність генерації ШІ, в 3 рази швидше редагування фотографій і в 10 разів більшу графічну продуктивність у порівнян...

Студенти MIT Media Lab створили Pienso для виявлення кібербулінгу, дезінформації тощо без кодування. Демонстрація в Білому домі сприяла розширенню можливостей доменних експертів для успішного використання ШІ.

LIDS Массачусетського технологічного інституту отримує грант ARC в розмірі $1,36 млн на проєкт з моделювання інтелектуальних мереж на основі штучного інтелекту. Співпраця з університетами та стартапами для революції в енергетичному секторі за допомогою генеративних моделей ШІ та платформи HILLTOP+.

Дослідники Массачусетського технологічного інституту розробили модель глибокого навчання для розвантаження роботизованих складів, підвищивши ефективність майже в чотири рази. Їхній інноваційний підхід може революціонізувати складні завдання планування, що виходять за рамки складських операцій.

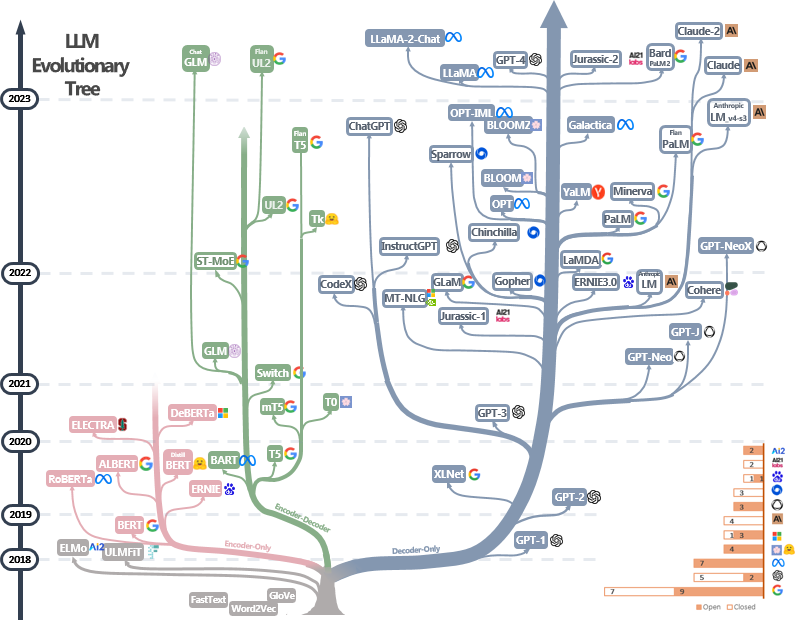

Захоплюючий розвиток великих мовних моделей (ВММ) революціонізував комунікацію, а підказки є ключем до використання їхніх здібностей до навчання в контексті. Такі компанії, як Prompting Llama та GPT-3.5, лідирують у розробці інноваційних стратегій підказок для LLM.

Дослідіть складний, але ефективний підхід ієрархічного навігаційного малого світу (HNSW) для швидкого пошуку найближчого сусіда. Пориньте в історію та тонкощі HNSW, щоб зрозуміти його високошвидкісні можливості.

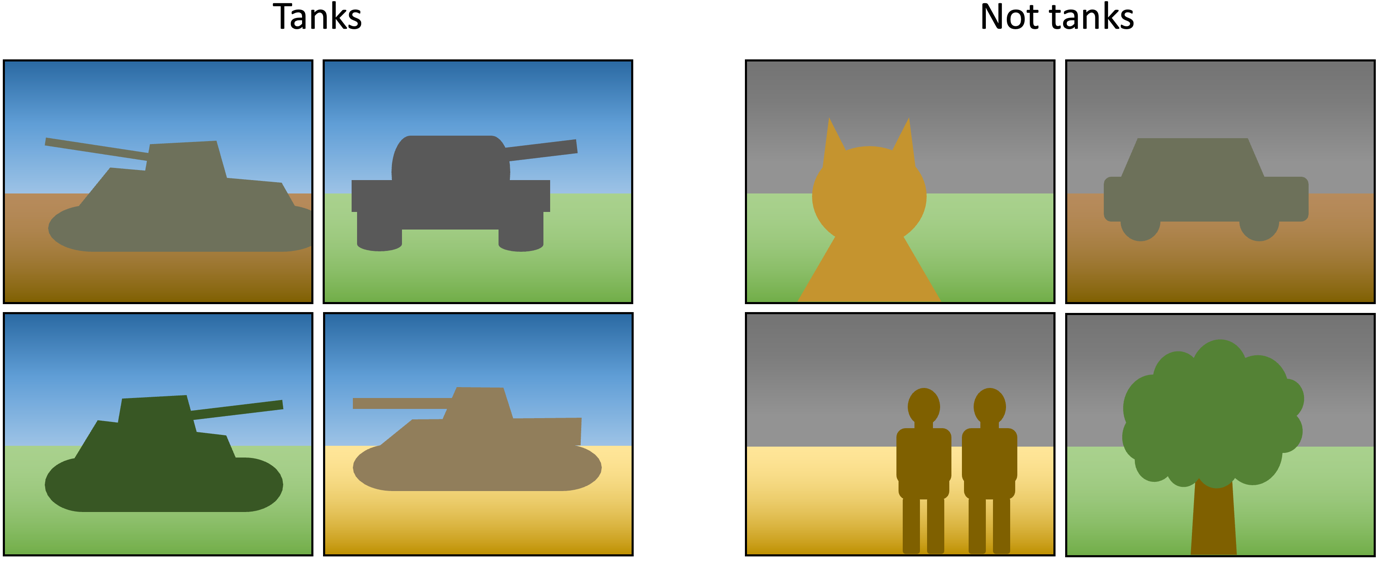

Пастки машинного навчання: надмірне налаштування, оманливі дані, приховані змінні. Приклади включають невдалі моделі прогнозування Covid та систему якості води. Контрольний список REFORMS запроваджено для запобігання помилкам у науці на основі ML.