Механізм уваги, що має вирішальне значення для машинного перекладу, допомагає ШНМ долати труднощі, що призвело до появи трансформерів. Самоувага в трансформерах включає вектори ключів, значень і запитів, щоб зосередитися на важливих елементах послідовності.

Трансформери революціонізують НЛП завдяки ефективним механізмам самоуваги. Інтеграція трансформаторів у комп'ютерний зір стикається з проблемами масштабування, але багатообіцяючі прориви вже на горизонті.

Досягнення штучного інтелекту об'єднали НЛП і комп'ютерний зір, що призвело до появи моделей підписів до зображень, подібних до тієї, що використовується в «Покажи і розкажи». Ця модель поєднує CNN для обробки зображень і RNN для генерації тексту, використовуючи GoogLeNet і LSTM.

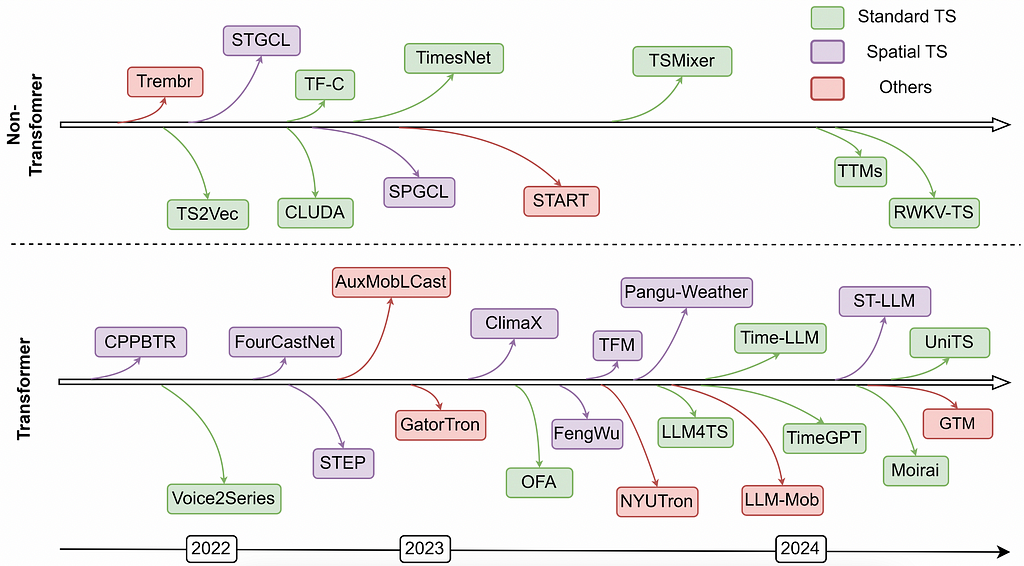

Фундаментальні моделі, такі як великі мовні моделі (LLM), адаптуються для моделювання часових рядів за допомогою великих фундаментальних моделей часових рядів (LTSM). Використовуючи подібність послідовних даних, LTSM має на меті навчатися на різноманітних даних часових рядів для таких завдань, як виявлення та класифікація викидів, спираючись на успіх LLM в обчислювальній лінгвістиці.

LSTM, представлені в 1997 році, повертаються разом з xLSTM як потенційні конкуренти LLM у глибокому навчанні. Здатність запам'ятовувати і забувати інформацію через певні проміжки часу відрізняє LSTM від RNN, роблячи їх цінним інструментом у моделюванні мови.

Поява таких інструментів, як AutoAI, може зменшити важливість традиційних навичок машинного навчання, але глибоке розуміння основних принципів ML все одно буде затребуваним. У цій статті розглядаються математичні основи рекурентних нейронних мереж (RNN) та досліджується їх використання для виявлення послідовних закономірностей у часових рядах даних.