Исследователи Массачусетского технологического института разработали модель машинного обучения, которая предсказывает переходные состояния химических реакций менее чем за секунду, помогая в разработке устойчивых процессов для создания полезных соединений. Модель может упростить процесс разработки фармацевтических препаратов и топлива, облегчив химикам эффективное использование богатых природны...

Руководители служб кибербезопасности сталкиваются со сложными вопросами о вероятности и стоимости взлома. Только 15 % используют количественное моделирование рисков, что создает определенные ограничения.

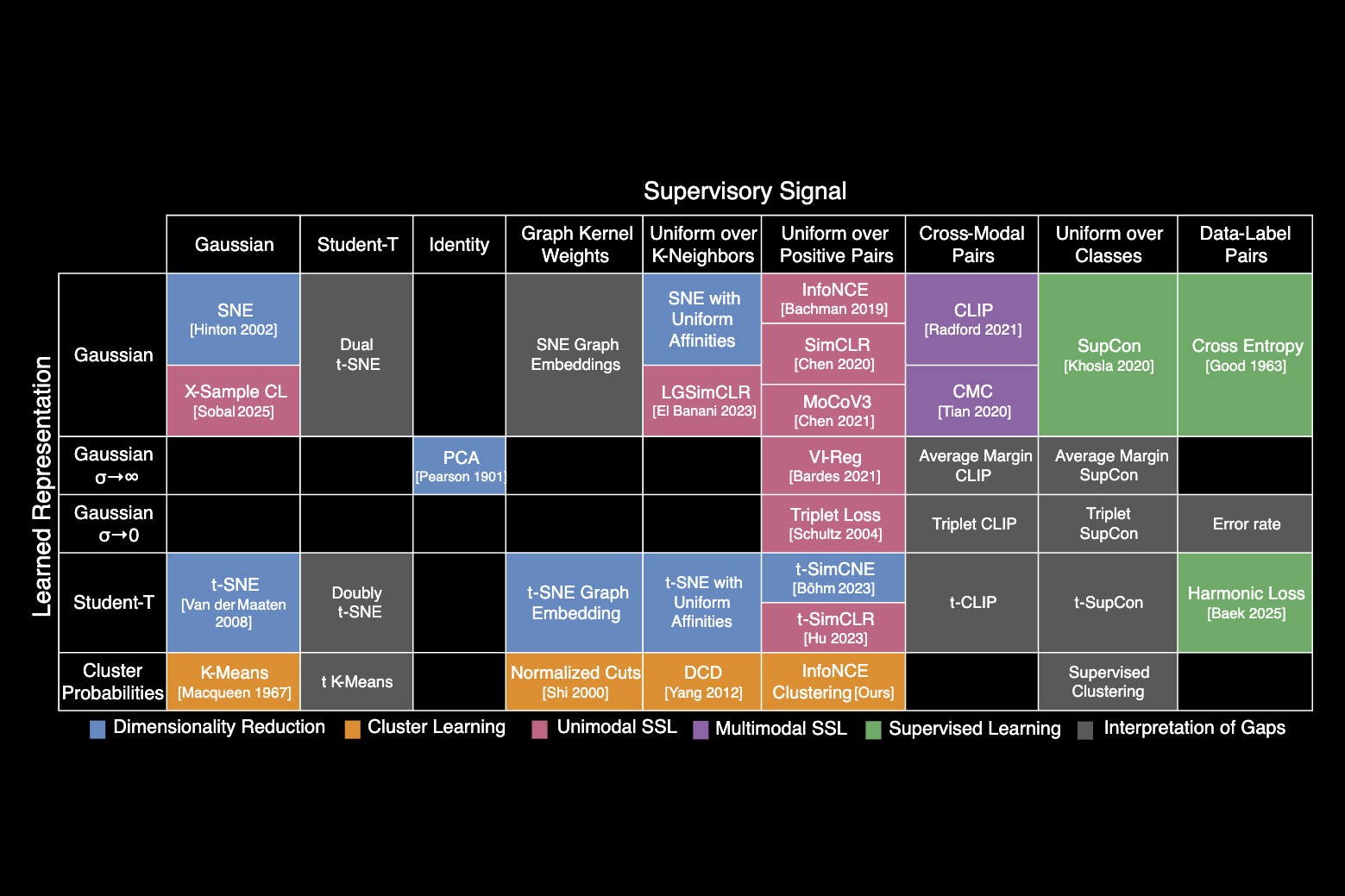

Исследователи Массачусетского технологического института составили периодическую таблицу алгоритмов машинного обучения, выявив связи и объединяющее уравнение. Таблица позволяет создавать новые модели ИИ, комбинируя элементы из разных методов.

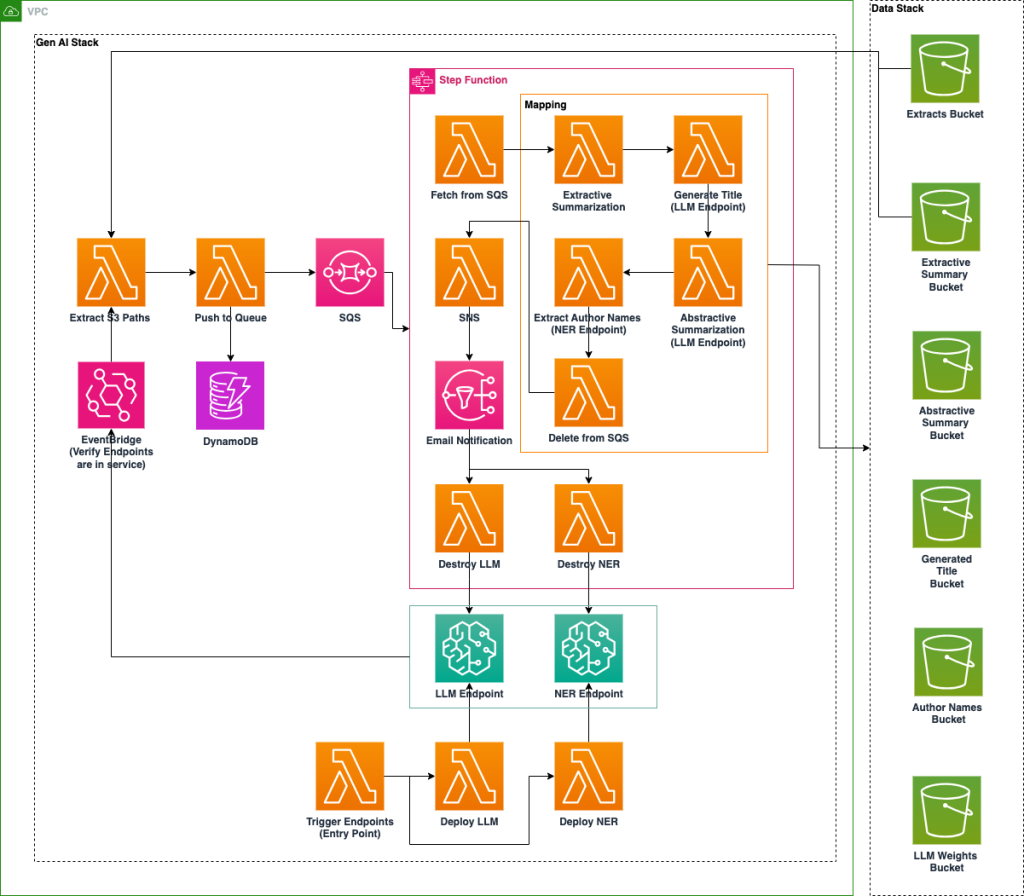

Национальная лаборатория США внедряет платформу искусственного интеллекта на базе Amazon SageMaker для повышения доступности архивных данных с помощью технологий NER и LLM. Оптимизированная по стоимости система автоматизирует обогащение метаданных, классификацию и обобщение документов для улучшения их организации и поиска.

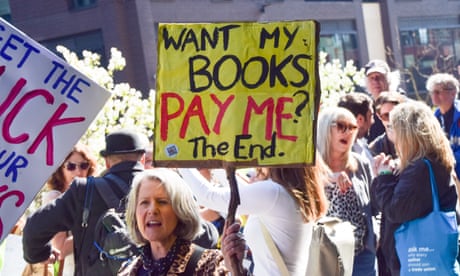

Издатели и писатели поддерживают новую коллективную лицензию британских лицензионных органов, позволяющую авторам получать компенсацию за обучение моделей искусственного интеллекта. Агентство по лицензированию авторских прав, возглавляемое Службой лицензирования издательств и Обществом лицензирования и коллекционирования авторов, представит эту новаторскую инициативу летом.

Выпуск DeepSeek-R1 конкурирует с Meta и OpenAI, предлагая расширенные возможности рассуждений за меньшую цену. Узнайте, как оценить дистиллированные модели DeepSeek-R1 с помощью признанных эталонов, таких как GPQA-Diamond.

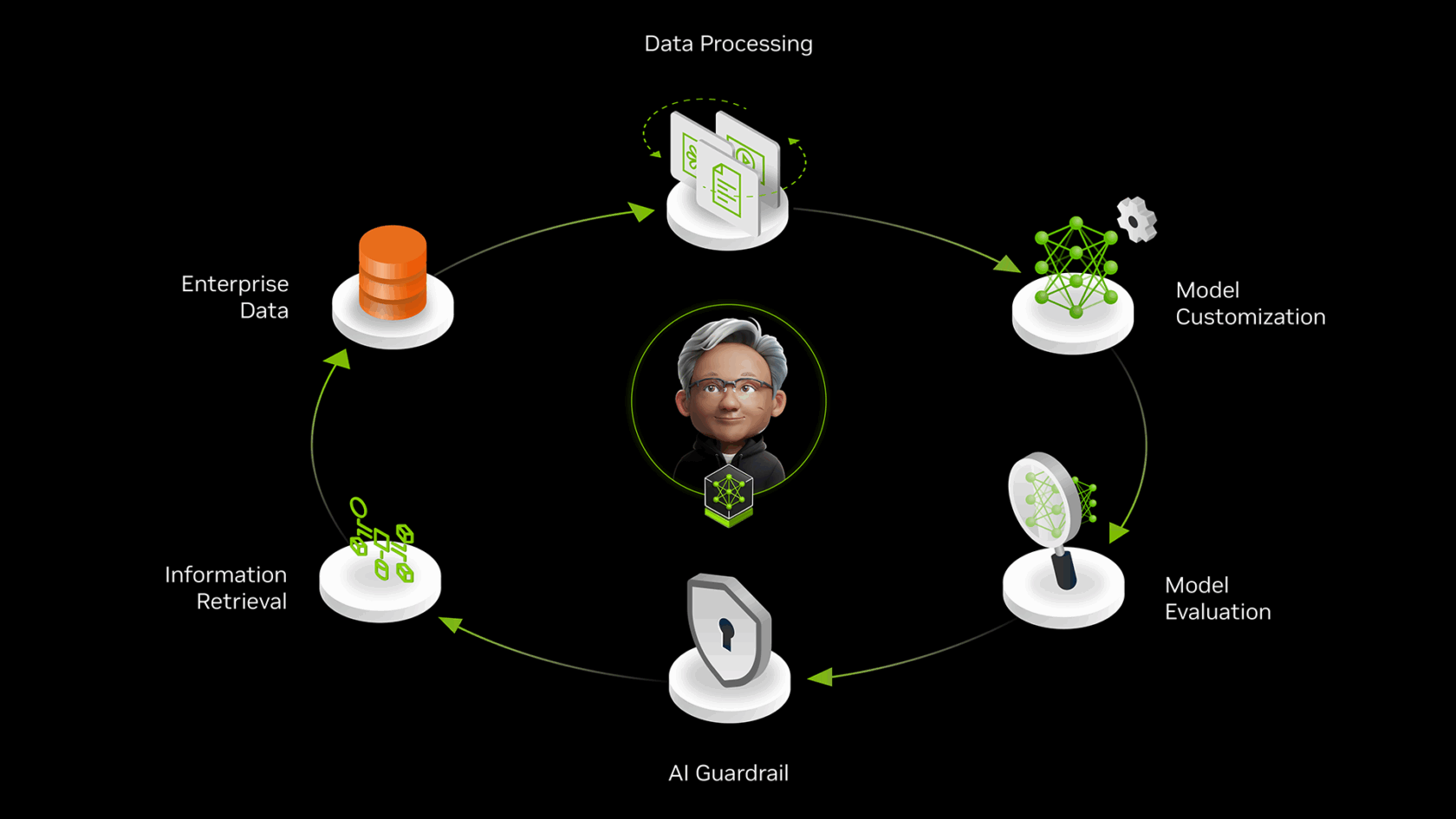

Микросервисы NVIDIA NeMo позволяют корпоративным ИТ-отделам создавать ИИ-команды, повышающие продуктивность за счет использования маховиков данных. Такие инструменты NeMo, как Customizer и Evaluator, помогают оптимизировать модели ИИ для точности и эффективности, повышая уровень соответствия и безопасности.

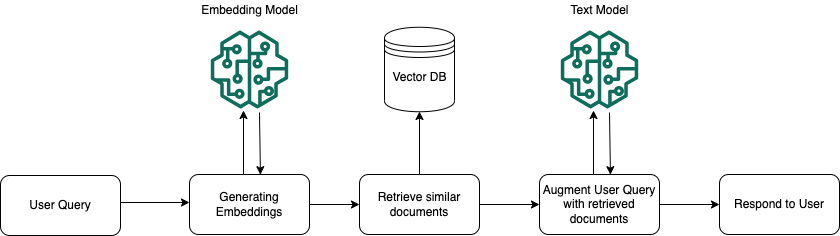

Приложения RAG улучшают задачи ИИ, предоставляя контекстно-значимую информацию, но требуют тщательных мер безопасности для защиты конфиденциальных данных. AWS предлагает генеративные стратегии безопасности ИИ, такие как Amazon Bedrock Knowledge Bases, для защиты конфиденциальности и создания соответствующих моделей угроз.

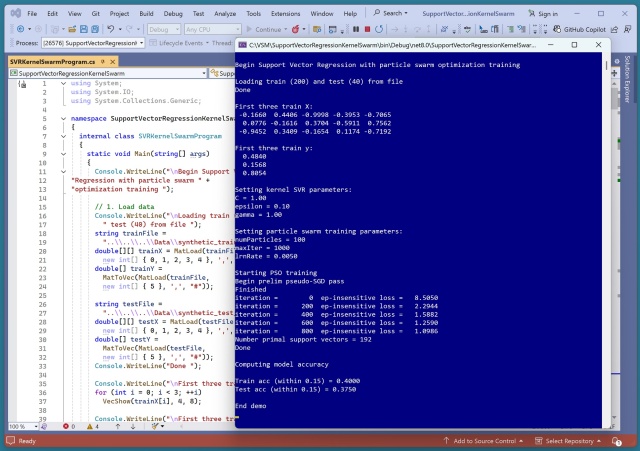

Кернелизированная SVR, обученная с помощью PSO, справляется с нелинейными данными с помощью RBF. Эпсилон-нечувствительные потери и PSO делают систему сложной, но многообещающей.

Резюме: Тестирование имеет решающее значение для выявления проблем в автомобильных мигалках или программном коде. Модульные, интеграционные и сквозные тесты играют ключевую роль в обеспечении функциональности и надежности.

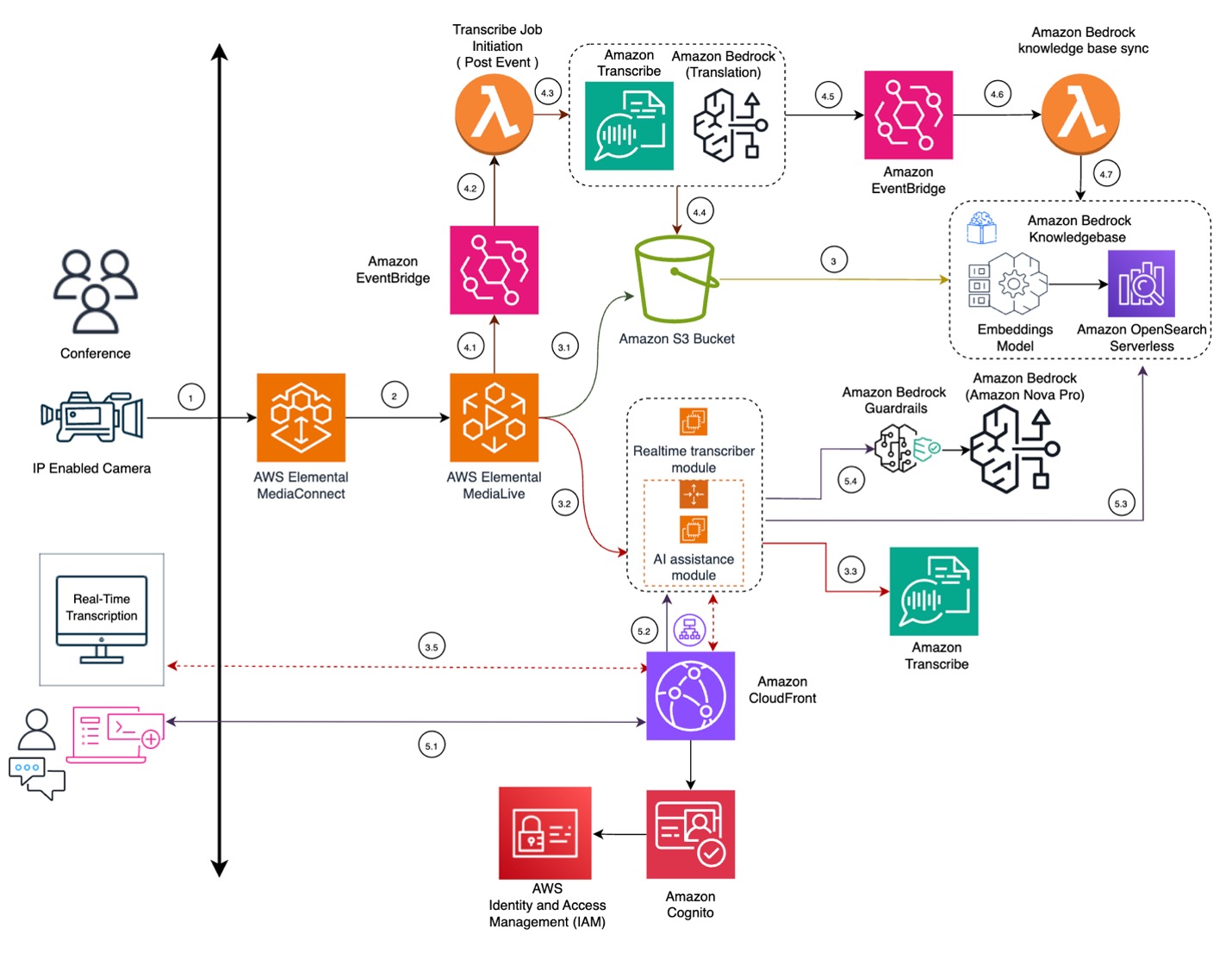

Компания Infosys Consulting совместно с партнерами Amazon Web Services разработала Infosys Event AI для улучшения обмена знаниями на мероприятиях. Event AI предлагает перевод, транскрипцию и поиск знаний в режиме реального времени, чтобы обеспечить доступ к ценным сведениям для всех участников, превращая контент мероприятия в поисковый ресурс знаний. Используя такие сервисы AWS, как Elemental ...

Выбор признаков имеет решающее значение для достижения максимальной эффективности модели. Регуляризация помогает предотвратить чрезмерную подгонку, штрафуя за сложность модели.

Молодым специалистам по обработке данных в технологической компании не хватало знаний о важнейших функциях ядра, в частности о функции радиального базиса (RBF). RBF измеряет сходство между векторами, причем существует два различных определения: одно включает сигму, а другое - гамму.

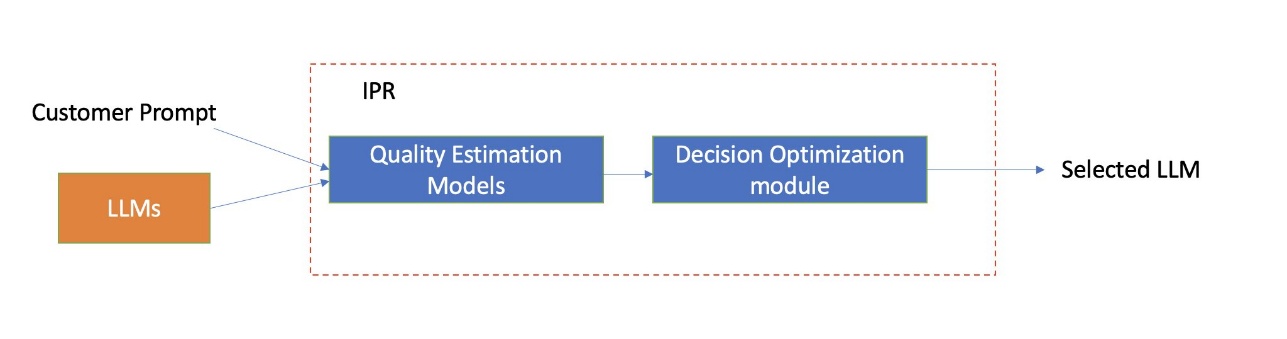

Интеллектуальная маршрутизация подсказок Amazon Bedrock теперь доступна в общем доступе, позволяя эффективно маршрутизировать между различными моделями фундаментов в зависимости от стоимости и качества ответа. Пользователи могут выбрать маршрутизаторы по умолчанию или настроить свои собственные для большего контроля над конфигурацией маршрутизации, с возможностью выбора моделей из семейств Ant...

Центры обработки данных с искусственным интеллектом переходят на системы жидкостного охлаждения, такие как NVIDIA GB200 NVL72 и GB300 NVL72, чтобы эффективно управлять теплом и энергозатратами и добиться значительной экономии. Жидкостное охлаждение обеспечивает более высокую плотность вычислений, увеличивает потенциал доходов и в 300 раз повышает эффективность использования воды по сравнению с...