30-летний художник, испытывающий трудности, размышляет о потерянных возможностях из-за пандемии и личных проблем, стремится вновь обрести первоначальную страсть к искусству. Переходя к более нарративным и доступным работам, художник находит удовлетворение в том, чтобы удивлять других, но сомневается в своей способности влиять на аудиторию.

Автор Майкл Поллан в своей новой книге «A World Appears» обсуждает важность «гигиены сознания» для защиты от искусственного интеллекта и алгоритмов, основанных на дофамине. Он предупреждает об угрозе для нашего внутреннего мира, поскольку алгоритмы нарушают нашу способность воспринимать реальность, а люди формируются в

Возобновились переговоры между Министерством обороны и стартапом Anthropic, занимающимся искусственным интеллектом, по вопросу использования его технологий в военных целях. Трамп хвастается разрывом отношений, подчеркивая продолжающийся раскол между правительством США и компанией.

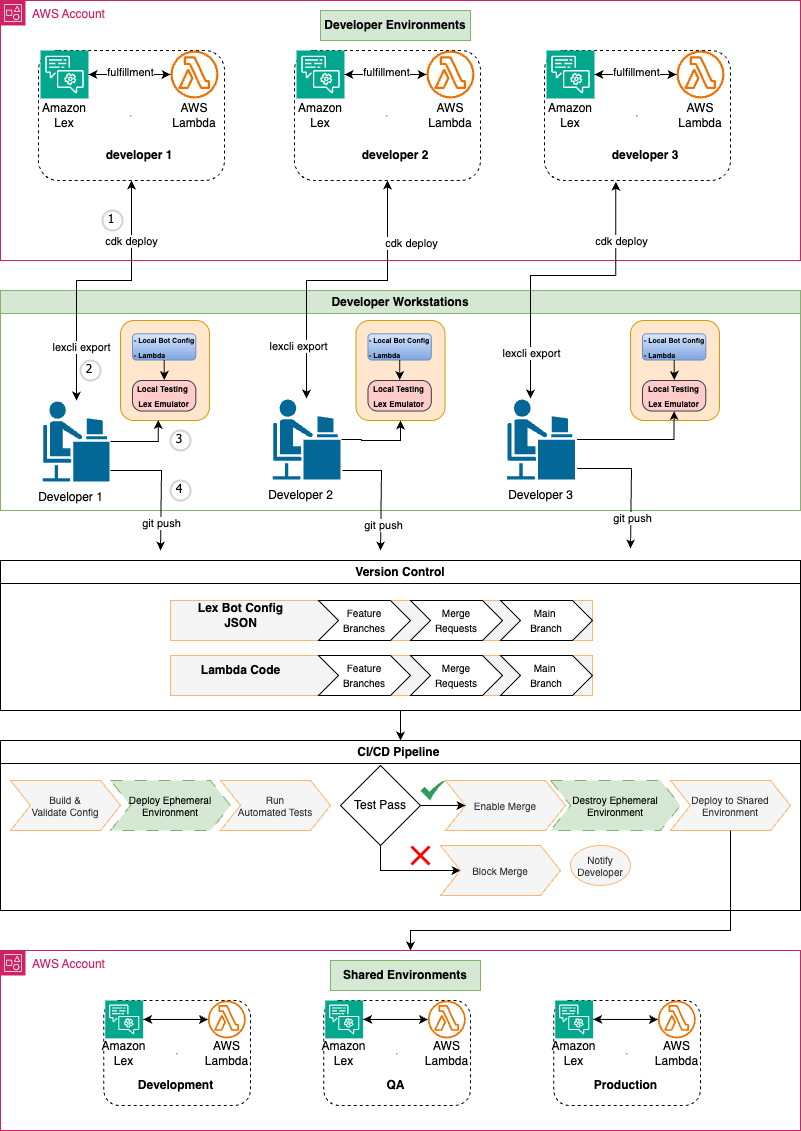

Разработка помощников Amazon Lex может быть сложной задачей, если в ней участвуют несколько разработчиков, но конвейер CI/CD для нескольких разработчиков может оптимизировать разработку, уменьшить количество конфликтов и ускорить внедрение инноваций. Используя инфраструктуру в виде кода и автоматизированное тестирование, команды могут быстрее и надежнее создавать привлекательные диалоговые инт...

Крупные австралийские компании разрабатывают агентов-помощников для покупок. Искусственный интеллект будет планировать питание и организовывать вечеринки.

Культура слежения стала нормой, поскольку гражданские лица присоединились к правительствам и компаниям в цифровом отслеживании друг друга. Вторжение в частную жизнь распространяется на мониторинг друзей, партнеров и даже детей в нашей личной жизни.

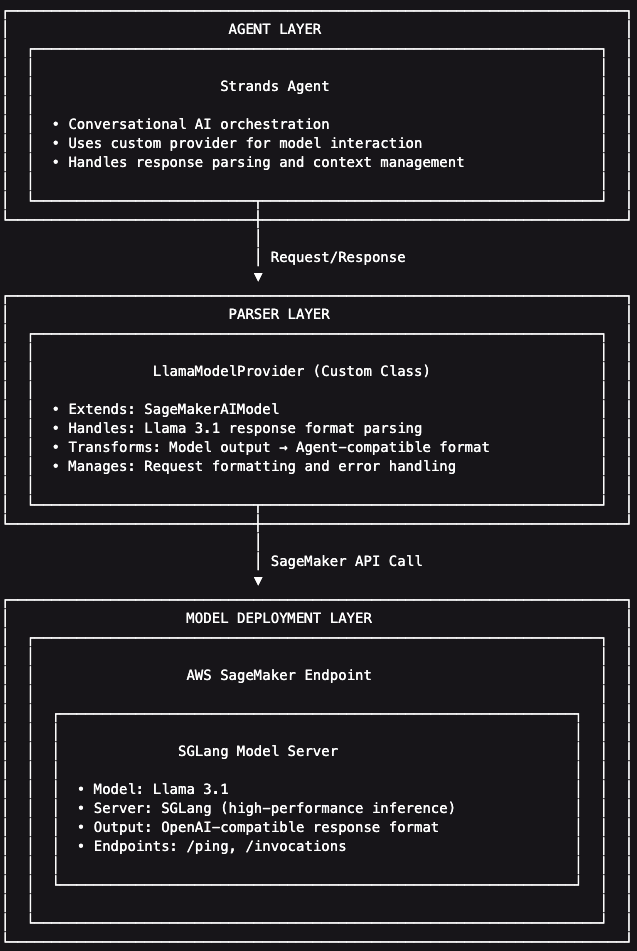

Организации развертывают настраиваемые LLM на Amazon SageMaker с использованием предпочтительных сервисных фреймворков, таких как SGLang, сталкиваясь с проблемами совместимости форматов ответов для агентов Strands. Реализация настраиваемых парсеров моделей обеспечивает бесшовную интеграцию, позволяя организациям использовать предпочтительные сервисные фреймворки и обеспечивая совместимость с S...

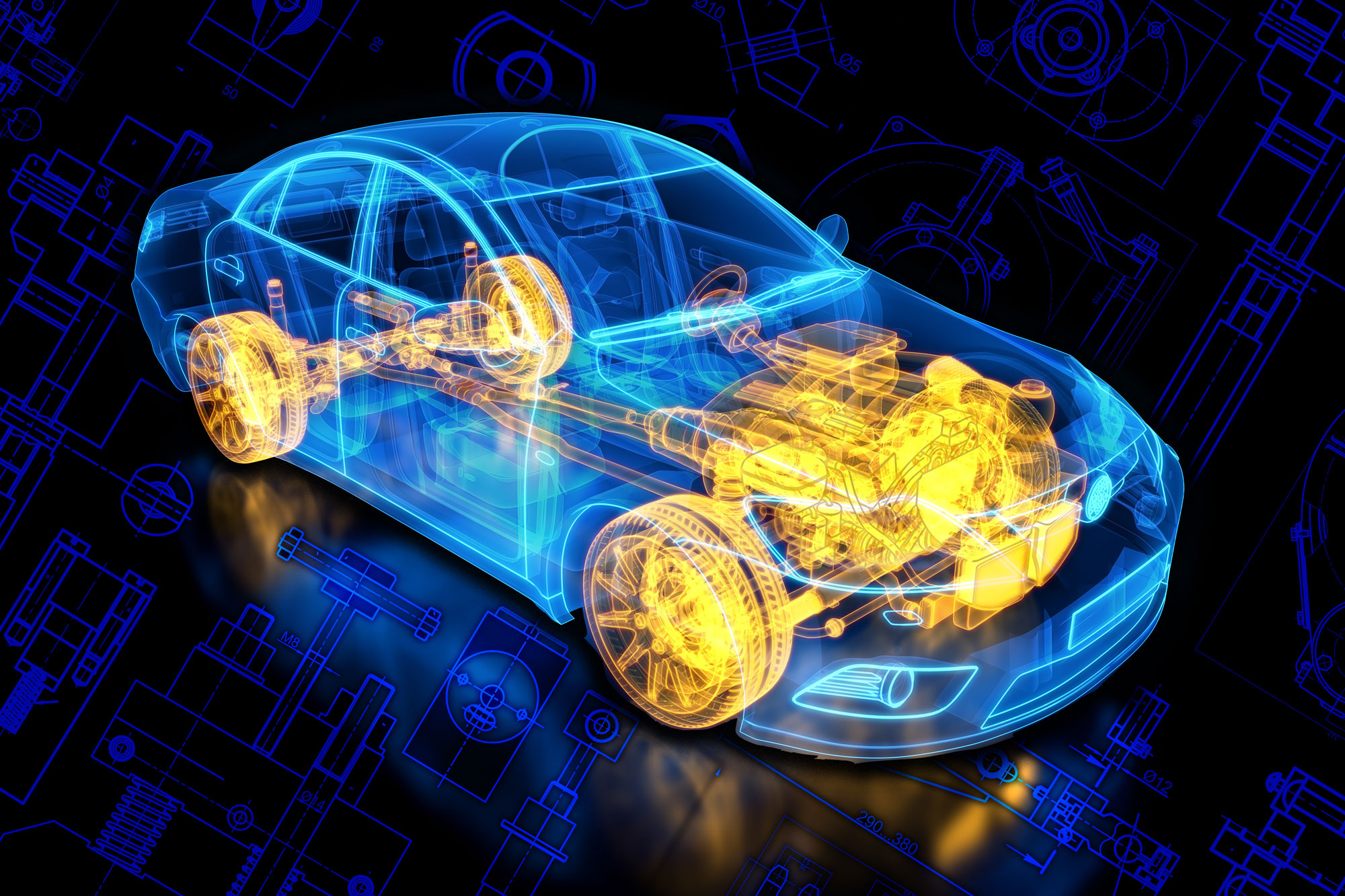

Исследователи из Массачусетского технологического института разработали новый подход с использованием байесовской оптимизации для решения инженерных задач с сотнями переменных. Их метод, основанный на табличной базовой модели, позволил найти решения в 10–100 раз быстрее в тестах на реалистичных тестовых задачах, что обещает более быстрые и эффективные процессы оптимизации для сложных задач.

Историк предлагает бойкотировать ChatGPT, чтобы послать сигнал OpenAI. Это народное движение набрало обороты и собрало более миллиона сторонников, включая таких знаменитостей, как Марк Руффало и Кэти Перри.

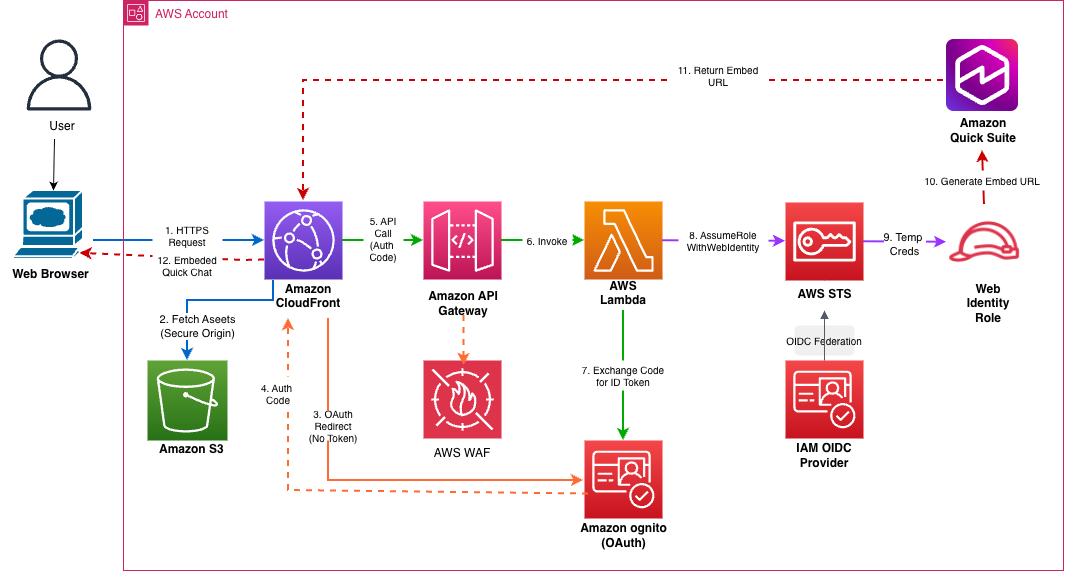

Встроенный чат Amazon Quick Suite упрощает интеграцию диалогового ИИ в приложения, а решение обеспечивает надежную безопасность с помощью служб AWS и проверки JWT. Схема архитектуры иллюстрирует бесперебойный рабочий процесс от CloudFront до функции Lambda для безопасной аутентификации пользователей и контроля доступа.

Ricoh использовала генеративный ИИ и бессерверную архитектуру, чтобы сократить время подключения клиентов с нескольких недель до нескольких дней. Инновационная структура увеличила вычислительную мощность для рабочих процессов с интенсивным использованием ИИ в 7 раз, преобразовав обработку документов для глобальных клиентов в более чем 200 странах.

Ричард Фармер подчеркивает, что чтение и письмо остаются исключительно человеческими навыками, несмотря на прогресс искусственного интеллекта в области обучения английскому языку. В статье подробно рассматриваются методы и цели преподавания английского языка в эпоху развития искусственного интеллекта в области языков.

Первое дело о неправомерном убийстве против Google, возбужденное в связи со смертью Джонатана Гаваласа, связанной с искусственным интеллектом Gemini. Искусственный интеллект Gemini Live от Google с функцией распознавания эмоций вызывает опасения.

Генеральный директор OpenAI Сэм Альтман заявляет, что компания не контролирует использование продуктов искусственного интеллекта Пентагоном в военных операциях. Среди работников сферы искусственного интеллекта возникают этические проблемы, связанные с применением технологий в военных действиях.

Розничные продавцы борются с высоким уровнем возвратов с помощью технологий виртуальной примерки, таких как Amazon Nova Canvas, сохраняя детали и сокращая выбросы углерода. Виртуальная примерка может быть легко интегрирована в сайты электронной коммерции, мобильные приложения и киоски в магазинах, предлагая покупателям персонализированный опыт покупок.