Функція глибоких досліджень OpenAI дозволяє за лічені хвилини робити вичерпні огляди літератури, розбиваючи запити на структуровані звіти. Доступна за підпискою OpenAI Plus або Pro, вона обіцяє багатокрокові дослідження з даними з Інтернету.

У Парижі в годину пік для зменшення заторів і забруднення обмежують пішохідну зону для спільного користування автомобілями. Смуга відкрита для громадського транспорту, таксі та екстрених служб.

Ефективне управління проектами під час розробки Python має вирішальне значення. Написання чистого коду, який можна підтримувати, має важливе значення для читабельності, налагодження, масштабованості та повторного використання у професійному середовищі. Популярність Python полягає в його простоті, зрозумілості та універсальності, але ефективність та ремонтопридатність проектів значною мірою зал...

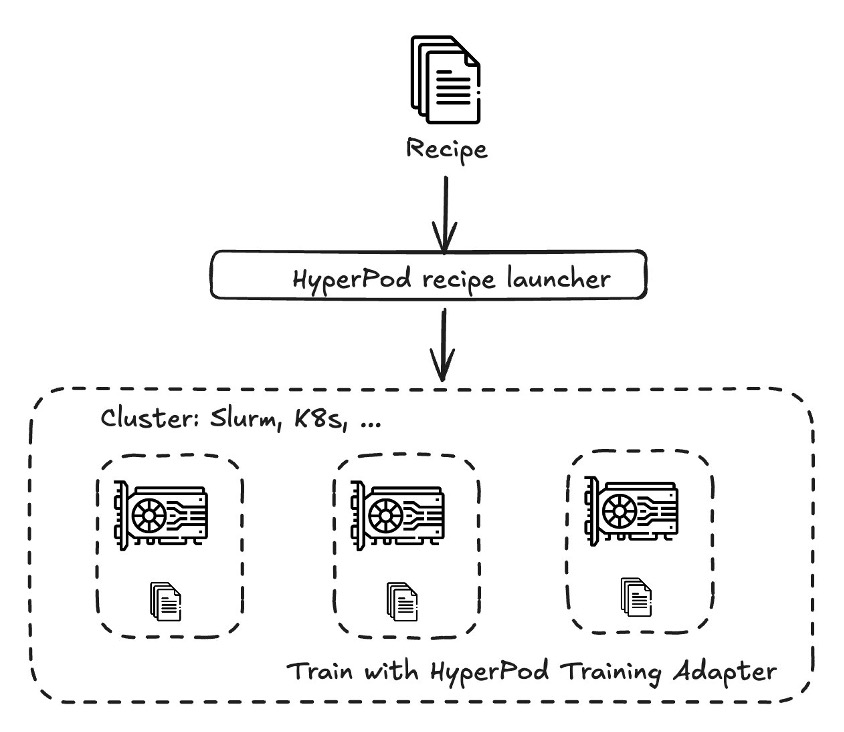

Організації налаштовують ШІ-моделі DeepSeek для конкретних випадків використання, стикаючись з проблемами в управлінні обчислювальними ресурсами. Рецепти Amazon SageMaker HyperPod спрощують кастомізацію моделей DeepSeek, досягаючи до 49% покращення результатів за шкалою Rouge 2.

Реакція, згенерована штучним інтелектом, наполягає на тому, що ШІ демократизує сторітелінг, протиставляючи аргумент LA Times як «лівоцентристський». Співдиректори Альянсу архівних продюсерів висловлюють занепокоєння щодо генеративних інструментів ШІ в кіноіндустрії.

ШІ, як і великі мовні моделі (ВММ), спрощує виконання щоденних завдань. Однак для конкретних бізнес-потреб генерація з розширеним пошуком (RAG) підвищує точність і релевантність, поєднуючи зовнішні знання з LLM.

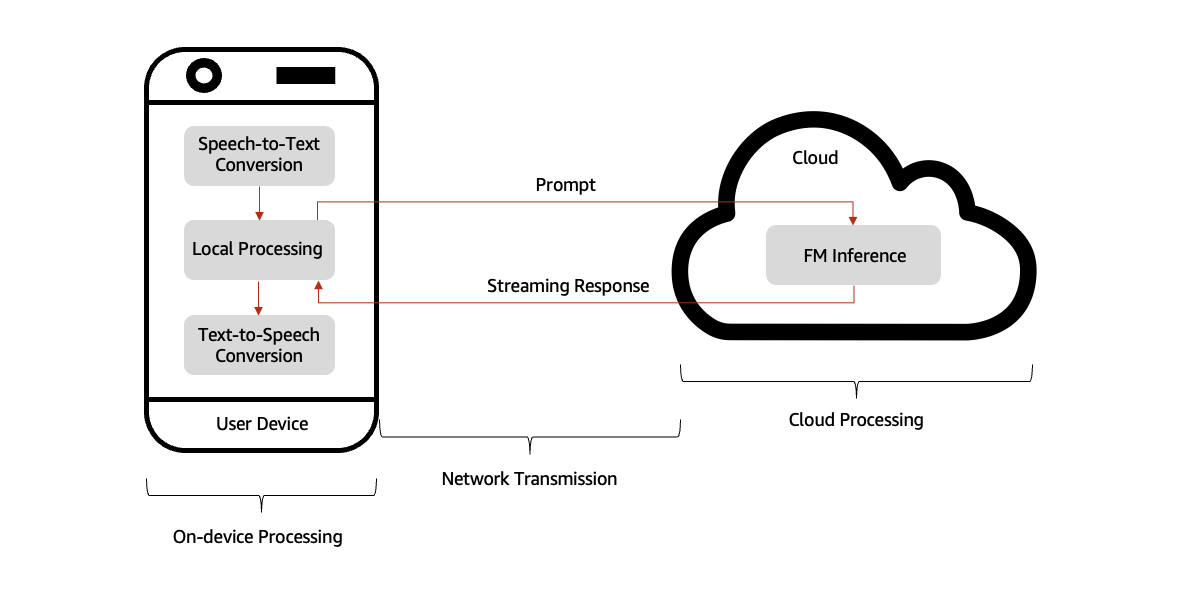

Досягнення в галузі генеративного ШІ сприяють створенню розмовних асистентів ШІ з можливістю взаємодії в режимі реального часу в різних галузях. Баланс між потужністю хмарного FM і швидкістю відгуку локального пристрою є ключовим для зменшення затримки відгуку нижче 200 мс.

Китай очікує на план Комуністичної партії щодо стимулювання економіки на тлі тарифів Трампа та ШІ-технологій DeepSeek. Щорічна парламентська сесія в Пекіні викликає заходи безпеки, що нагадують минулі протести.

Газета LA Times запроваджує інструмент «Інсайт», створений штучним інтелектом, для авторських статей, що викликало суперечки між співробітниками та власником Патріком Сун-Шіонгом. Інструмент надає рейтинг політичного контенту та альтернативні погляди, застосовуючись лише до авторських статей, а не до новинних репортажів.

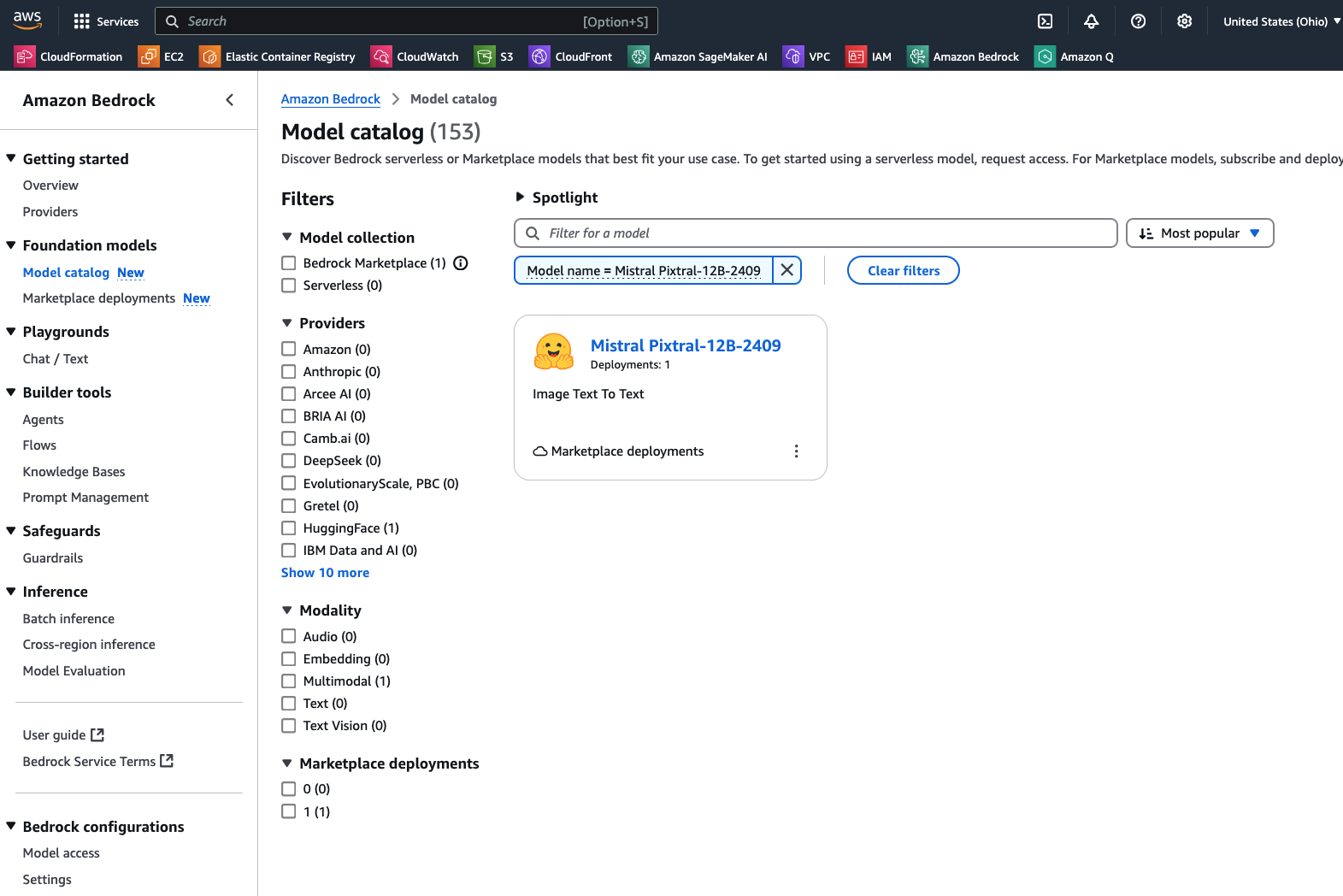

Pixtral 12B, найсучасніший ШНМ Mistral AI з 12 мільярдами параметрів, чудово справляється з текстовими та мультимодальними завданнями, доступний на Amazon Bedrock Marketplace. Нова архітектура моделі забезпечує високопродуктивне розуміння зображень і документів, перевершуючи відкриті моделі в різних тестах.

ШІ допомагає зберегти дику природу в усьому світі, а такі некомерційні організації, як Ai2, використовують ШІ від NVIDIA для захисту слонів та інших видів тварин. Платформа EarthRanger пропонує дані в реальному часі для прийняття обґрунтованих рішень, прогнозування та запобігання конфліктам між людиною та дикою природою.

МКП закликає посилити захист авторських прав та ШІ, щоб запобігти експлуатації креативних індустрій технологічними босами. Профспілки наголошують на необхідності належного захисту працівників перед обличчям технологічного прогресу.

Професор Ендрю Моран та доктор Бен Вілкінсон обговорюють розвиток штучного інтелекту в університетських есе, кидаючи виклик традиційним джерелам знань. «Тіндерфікація» знань змінює суспільний дискурс і підриває критичне мислення.

Нова книга Карпа та Заміської досліджує ШІ, національну безпеку та вплив Кремнієвої долини. Співзасновник компанії Palantir, Карп має багатий досвід та зв'язки, що викликають інтригу в технологічній індустрії.

Адміністрація Трампа звільняє 6 700 працівників Податкової служби під час податкового сезону, що спричиняє хаос. Порушення роботи ШІ матиме далекосяжні наслідки, які не обмежаться лише звільненням працівників податкової служби.