WPP планує стати «простішою, дешевшою компанією, що використовує штучний інтелект», щоб до 2028 року заощадити 500 млн фунтів стерлінгів на рік за рахунок продажу активів і скорочення робочих місць. Радикальна реструктуризація спрямована на протидію загрозі зростання штучного інтелекту і коштуватиме 400 млн фунтів стерлінгів протягом двох років.

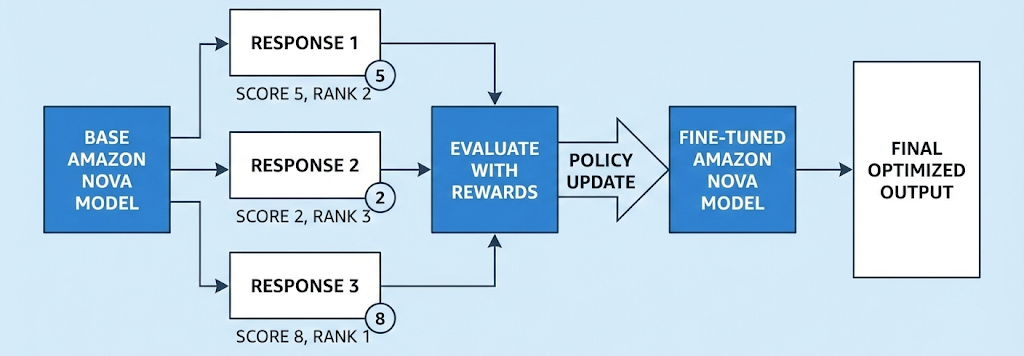

Базові моделі чудово справляються із загальними завданнями, але надзвичайно важливо налаштовувати моделі з урахуванням бізнес-знань. Amazon впроваджує підсилене налаштування для моделей Nova, переходячи від імітації до парадигми оціночного навчання, пропонуючи індивідуальні рішення для генерації коду та математичного міркування.

Британські медіакомпанії, включаючи BBC та Financial Times, шукають глобальні механізми для захисту журналістики від несанкціонованого використання компаніями, що займаються штучним інтелектом. Коаліція під керівництвом Guardian має на меті забезпечити справедливу компенсацію за оригінальний контент, щоб гарантувати стабільність галузі.

Дізнайтеся про регресію на основі дерева рішень, реалізовану з нуля за допомогою C# без покажчиків або рекурсії, у журналі Visual Studio Magazine. Дерева рішень забезпечують інтерпретованість і можуть використовуватися окремо або в ансамблях для завдань регресії.

Брейді Ткачук, капітан команди НХЛ «Оттава Сенаторс», вибачився за жарт Трампа, який образив канадців після перемоги США над Канадою на Зимових Олімпійських іграх. Відео Білого дому, створене за допомогою штучного інтелекту, показує суперечливу реакцію Ткачука.

Burger King впроваджує чат-бот на базі штучного інтелекту для контролю ввічливості співробітників, що викликало суперечки. BK Assistant від OpenAI має на меті аналізувати моделі обслуговування з використанням зворотного зв'язку в режимі реального часу.

Сучасні великі мовні моделі (LLM) стикаються з проблемою зростання витрат через збільшення кількості токенів. Нова підтримка LMCache від AWS забезпечує зниження витрат і підвищення продуктивності для робочих навантажень з довгим контекстом, змінюючи підхід організацій до обробки повторюваних «гарячих точок» даних.

Піт Хегсет погрожує розірвати контракт на суму 200 мільйонів доларів, якщо йому не буде надано необмежений доступ до моделі Claude компанії Anthropic. Anthropic відмовляється виконати вимогу Пентагону про скасування заходів безпеки для моделі штучного інтелекту, ризикуючи бути визнаною «ризиком для ланцюга поставок».

Працівники відчувають себе знеціненими через технології штучного інтелекту і побоюються зниження якості роботи. Аналіз МВФ передбачає вплив штучного інтелекту на 40% робочих місць у світі, порівнюючи це з цунамі на ринку праці.

Штучний інтелект прискорює модернізацію COBOL, але для досягнення успіху необхідний повний контекст і платформоорієнтований вхідний сигнал для прямого інжинірингу. Модернізація мейнфреймів залежить від зворотного інжинірингу та простежуваної основи для помічників з кодування на базі штучного інтелекту.

Активісти, які виступають за рівність у сфері технологій, критикують уряд за залучення приватних технологічних компаній до впровадження штучного інтелекту. Міністри консультуються з аналітичним центром Тоні Блера та такими компаніями, як IBM, Accenture, а також колишніми керівниками Google і Facebook.

Дослідники з Інституту Броуда при Массачусетському технологічному інституті та Гарвардському університеті, а також з ЕТН Цюріх/Інституту Пауля Шеррера розробили систему штучного інтелекту, яка аналізує дані про клітини, отримані в результаті різних вимірювань, щоб забезпечити цілісний погляд на проблему та допомогти в розумінні таких захворювань, як рак та хвороба Альцгеймера. Головний автор д...

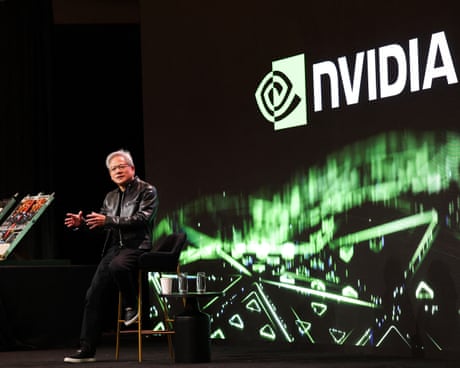

Nvidia продовжує перевершувати очікування Уолл-стріт завдяки вищим, ніж очікувалося, доходам від бізнесу центрів обробки даних, що зумовлено інвестиціями в інфраструктуру штучного інтелекту. Домінування виробника мікросхем на ринку підкреслюється його 75-відсотковим зростанням у порівнянні з минулим роком і вражаючим загальним прибутком у розмірі 120 млрд доларів за фінансовий рік.

Дослідники з Массачусетського технологічного інституту (MIT) розробили метод прискорення навчання великих мовних моделей за допомогою використання незайнятих процесорів. Навчивши меншу модель прогнозувати результати роботи більшої моделі, вони подвоїли швидкість навчання без втрати точності.

Моделі GenAI часто не розуміють фізики, що призводить до створення непрактичних 3D-дизайнів. Система PhysiOpt від MIT покращує дизайн за допомогою фізичних симуляцій для структурно міцних об'єктів, що дозволяє користувачам легко створювати унікальні та функціональні предмети.