Президент Франції Макрон захищає регулювання ЄС у сфері штучного інтелекту від критики з боку США та обіцяє захищати дітей від цифрового насильства. Макрон закликає до посилення заходів безпеки після скандалу, пов'язаного з чат-ботом Grok Ілона Маска, та побоювань щодо монополій у сфері штучного інтелекту.

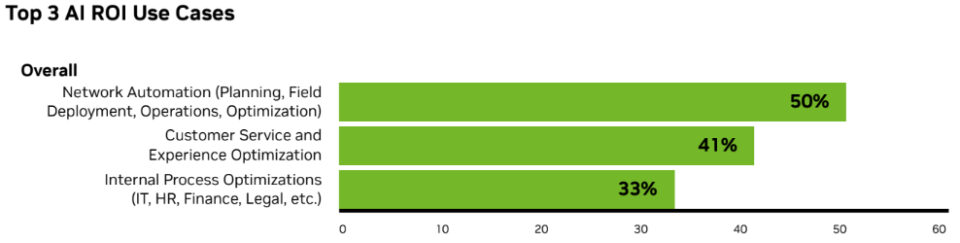

Штучний інтелект змінює телекомунікаційну галузь: 90% компаній відзначають зростання доходів і зниження витрат. 77% очікують появи мереж на базі штучного інтелекту до появи 6G, а 89% планують збільшити витрати на штучний інтелект у 2026 році.

Губернатор штату Іллінойс Дж. Б. Пріцкер пропонує припинити податкові пільги для центрів обробки даних через негативну реакцію громадськості на ресурсоємні об'єкти, що забезпечують бум штучного інтелекту. Пропозиція, яка потребує схвалення законодавцями штату, була оприлюднена під час виступу Пріцкера про стан справ у штаті, як повідомляє NBC News.

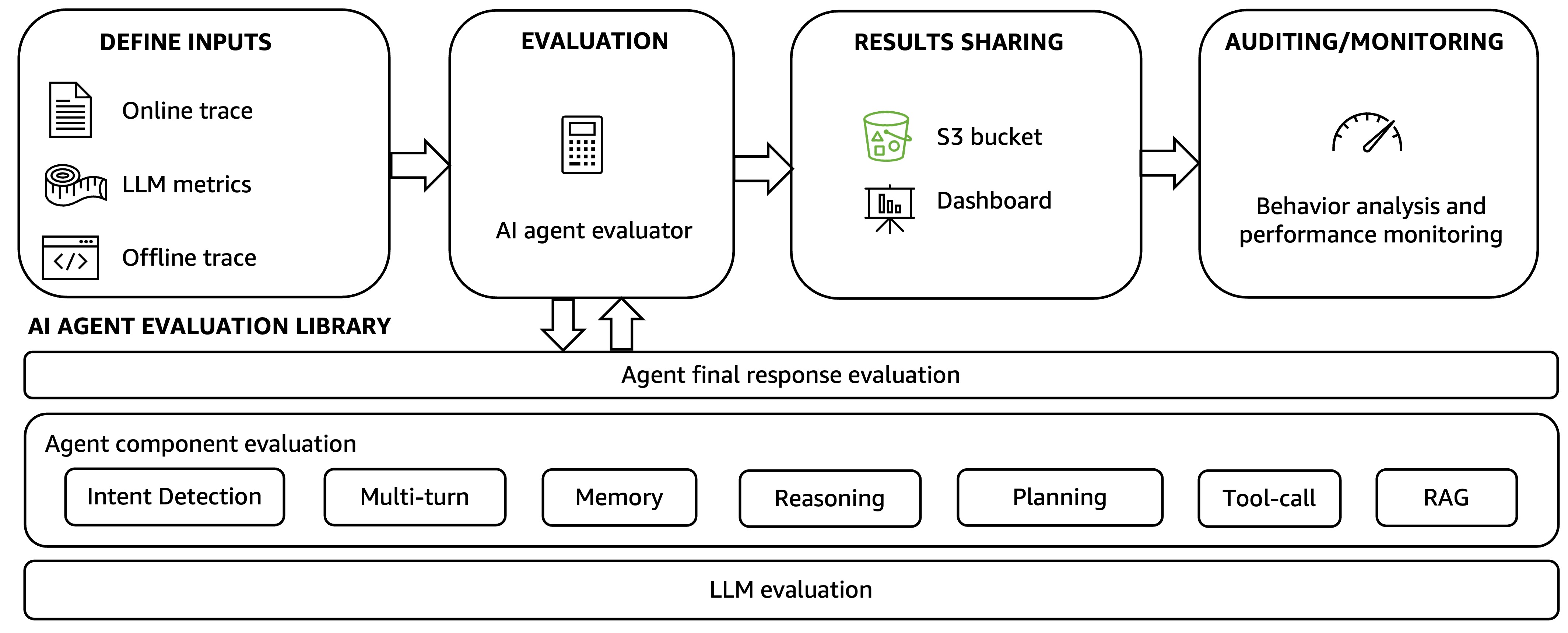

Індустрія генеративної штучної інтелекту переходить від систем на основі великих мовних моделей (LLM) до агентських систем штучного інтелекту, що забезпечують динамічні, орієнтовані на цілі можливості. Amazon лідирує з тисячами створених агентів, що вимагає нової системи оцінки поведінки систем і рівня виконання завдань у виробничих середовищах.

Раціональні ШІ не повинні мати цілей, а повинні узгоджувати дії з практикою. Евдемонічна раціональність має вирішальне значення для узгодження ШІ та процвітання людства.

Колишній міністр фінансів Великобританії Джордж Осборн застерігає країни, що вони повинні прийняти штучний інтелект, такий як OpenAI, щоб не відставати, не слабшати і не біднішати. Осборн, який зараз очолює програму OpenAI «для країн», наголошує на важливості впровадження штучного інтелекту для запобігання міграції робочої сили в пошуках можливостей, пов'язаних зі штучним інтелектом.

Дослідники Массачусетського технологічного інституту розробили нову систему навігації для паркування, яка враховує наявність вільних місць і дозволяє заощадити до 66% часу на дорогу. Такий підхід може сприяти переходу на громадський транспорт та альтернативні засоби пересування.

Штучний інтелект рекламується як засіб скорочення робочого тижня, але дисбаланс сил може перешкоджати досягненню позитивних результатів. Компанії впроваджують штучний інтелект для кращого балансу між роботою та особистим життям.

Білл Гейтс відмовляється від участі в індійському саміті AI Impact Summit, щоб зосередитися на ключових пріоритетах на тлі питань про його зв'язки з Джеффрі Епштейном. Мільярдер і співзасновник Microsoft мав виступити на заході, де його фонд співпрацює з урядом Індії в галузі штучного інтелекту для суспільного блага.

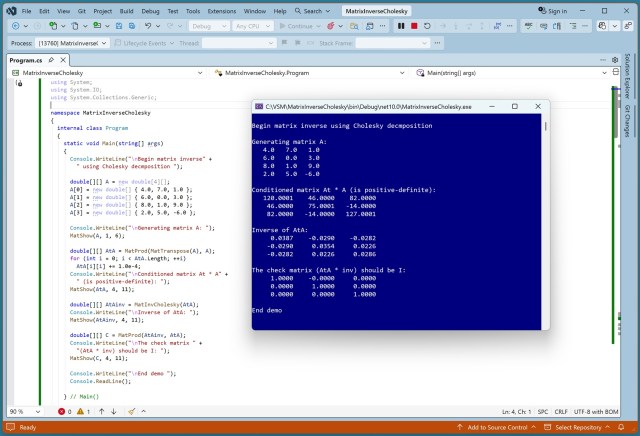

Існує безліч алгоритмів обернення матриць, що підкреслює складність цього процесу. Розклад Чолеського ідеально підходить для квадратних, симетричних, позитивно визначених матриць у сценаріях машинного навчання.

Прем'єр-міністр Іспанії закликає провести розслідування щодо X, Meta та TikTok за можливі кримінальні злочини, пов'язані з матеріалами про сексуальне насильство над дітьми, з метою покласти край безкарності онлайн-платформ та захистити психічне здоров'я і права дітей. Іспанія вживає заходів для притягнення до відповідальності гігантів соціальних медіа, очолюваних прем'єр-міністром Педро Санчес...

Дослідники з MIT та Penn State виявили, що функції персоналізації у великих мовних моделях можуть призвести до підлещування, зниження точності та поширення дезінформації. Тривалі взаємодії з LLM можуть створювати ехо-камери, що підкреслює важливість розуміння їх динамічної поведінки.

Технологічні мільярдери з Google, Anthropic та OpenAI візьмуть участь у саміті з питань штучного інтелекту, який організовує Нарендра Моді в Делі. Лідери країн південної півкулі змагатимуться за контроль над технологіями штучного інтелекту на тижневому заході, в якому візьмуть участь технологічні компанії з капіталом у трильйони доларів.

Стартапи в галузі штучного інтелекту в Сан-Франциско вимагають від співробітників безперервної працездатності, стираючи межі між роботою та особистим життям. Засновник працює 7 днів на тиждень по 12 годин на день, що свідчить про інтенсивний тиск в економіці штучного інтелекту.

Професор Майкл Вулдрідж попереджає, що смертельне оновлення безпілотного автомобіля або злом штучного інтелекту можуть зруйнувати глобальну довіру до технологій. Комерційний тиск спонукає до поспішного виведення на ринок нових інструментів штучного інтелекту, не до кінця зрозумівши їхні можливості та недоліки.