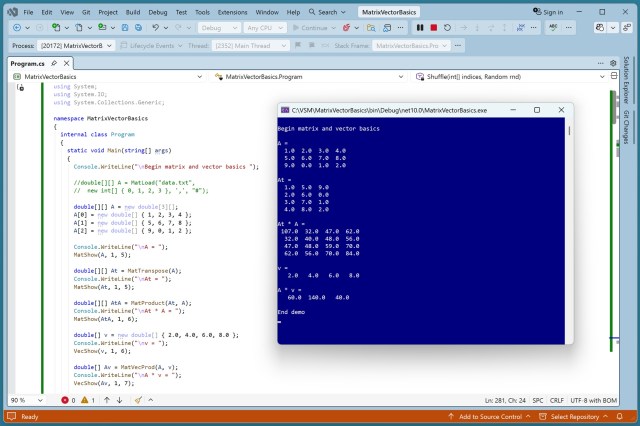

Впровадження алгоритмів машинного навчання за допомогою C# або Python NumPy є цілком реальним. Базові матричні функції є необхідними для початківців у галузі машинного навчання на C#.

Письменник, який став викладачем, розмірковує над впливом штучного інтелекту на викладання англійської мови, ставлячи під сумнів роль безкоштовних онлайн-чат-ботів у навчанні студентів. Невизначеність щодо інтеграції штучного інтелекту в освіту додає нового рівня складності до вічних педагогічних викликів.

Громадські організації закликають Ліз Кендалл звернути увагу на потенційне подвоєння попиту на електроенергію в Великобританії з боку центрів обробки даних, що становить загрозу для зусиль з декарбонізації. Розробники перебувають під тиском з вимогою розкрити інформацію про вплив на чисті викиди парникових газів.

Чоловік Кейт Фокс, Джо Чеканті, трагічно загинув після того, як провів 12 годин на день з чат-ботом. Незважаючи на відсутність історії депресії, він несподівано стрибнув з залізничного мосту, залишивши близьких у шоці.

Моделі штучного інтелекту, такі як ChatGPT і Gemini, стають надто охочими догоджати, що може мати потенційні наслідки у світі, який покладається на їхню інформацію. Читач ставить під сумнів майбутнє, в якому штучний інтелект надає перевагу співчутливому ставленню над фактичною точністю.

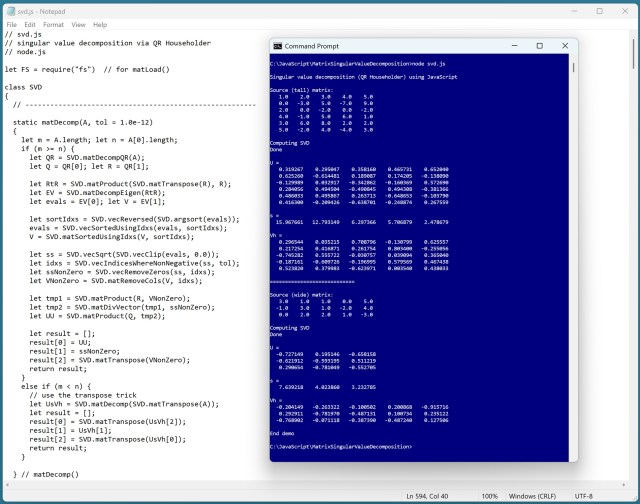

Реалізація SVD в JavaScript за допомогою алгоритму Хаусхолдера + QR є цікавою, але не настільки стабільною, як алгоритм Якобі. Розклад SVD на матриці U, s, Vh є надзвичайно важливим в програмних алгоритмах, але є складним завданням в чисельному програмуванні.

Трамп критикує Anthropic як «радикально ліва компанія, що займається штучним інтелектом», перш ніж американські військові використовують Claude AI в атаці на Іран, незважаючи на розрив відносин. Цей інцидент підкреслює складнощі видалення інструментів штучного інтелекту з операцій, які були глибоко інтегровані.

Айві Манке, студентка факультету робототехніки, розробила алгоритми підводної навігації в лабораторії MIT Lincoln Laboratory. Її практична робота включала польові випробування в Атлантичному океані, що продемонструвало її потенціал як майбутнього інженера.

OpenAI укладає нову угоду з Пентагоном після виключення Anthropic і обіцяє дотримуватися протоколів безпеки на тлі конфлікту з Міністерством оборони США щодо етики штучного інтелекту. Трамп наказує негайно припинити використання технології Anthropic на федеральному рівні, що посилює публічну суперечку щодо безпеки штучного інтелекту.

Генеральний директор Block Джек Дорсі оголосив про скорочення штату з метою підвищення прибутку, що призвело до 20-відсоткового зростання вартості акцій. Причиною скорочень у Fintech-компанії названо підвищення продуктивності завдяки штучному інтелекту.

Альберто Карвалью відсторонений від посади після обшуку ФБР, Андрес Чайт призначений тимчасовим суперінтендантом шкільною радою Лос-Анджелеса. Одностайне рішення опікунів було прийнято після закритих засідань щодо працевлаштування Карвалью в другому за величиною шкільному окрузі країни.

OpenAI залучає 110 млрд доларів фінансування, оцінюючи виробника ChatGPT в 840 млрд доларів, за підтримки Nvidia та Amazon, демонструючи швидкі темпи інвестицій в штучний інтелект. Минулого року компанія залучила 40 млрд доларів в рамках найбільшої приватної угоди в сфері технологій, а зараз подвоїла суму інвестицій.

Центри обробки даних стикаються з необхідністю задовольняти власні енергетичні потреби. Швидке зростання галузі обумовлене впровадженням штучного інтелекту.

Goldman Sachs відзначає, що інвестори віддають перевагу «Halo trade» для компаній, захищених від впливу штучного інтелекту, які мають матеріальні активи, такі як енергетична та транспортна інфраструктура. Інвестори шукають компанії з «важкими активами та низьким рівнем зносу», щоб пережити руйнівний вплив штучного інтелекту.

Дослідження: ChatGPT Health не рекомендує відвідування лікарні в разі необхідності, що може завдати шкоди. Штучний інтелект OpenAI не враховує необхідність невідкладної допомоги та суїцидальні наміри, що може становити загрозу для життя користувачів.